文章目录

- research

- 1.《Do Transformers Really Perform Bad for Graph Representation》【NeurIPS 2021 Poster】

- 2.《Relational Attention: Generalizing Transformers for Graph-Structured Tasks》【ICLR2023-spotlight】

- survey

推荐一个汇总Graph Transformer论文的项目:awesome-graph-transformer

推荐一个串讲Graph Transformer的推送:一文带你浏览Graph Transformers

research

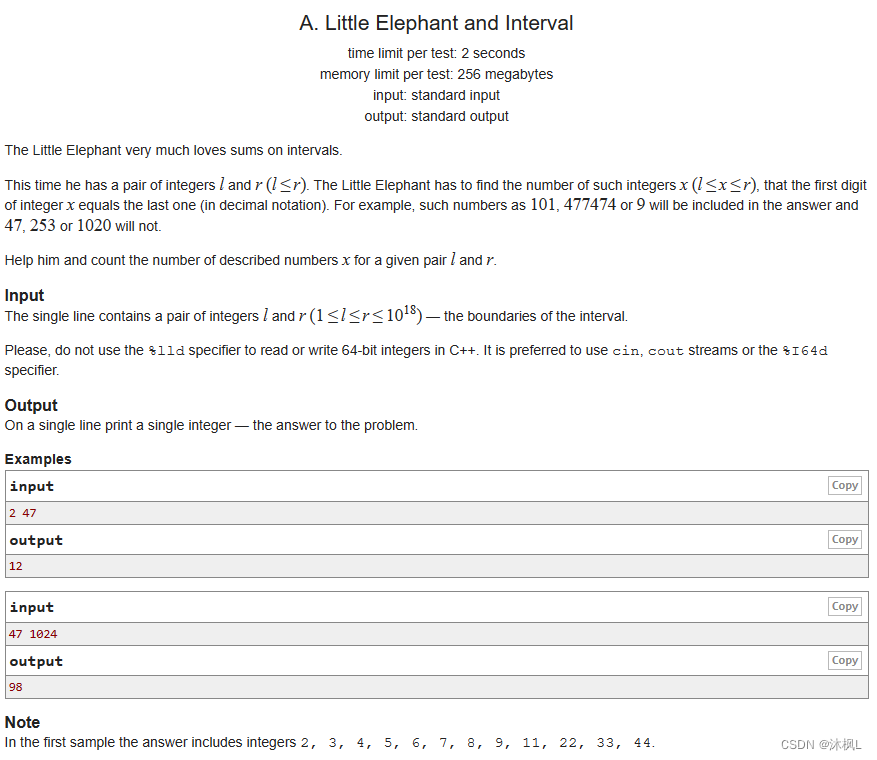

1.《Do Transformers Really Perform Bad for Graph Representation》【NeurIPS 2021 Poster】

\quad 原作者对论文的解读:https://www.msra.cn/zh-cn/news/features/ogb-lsc

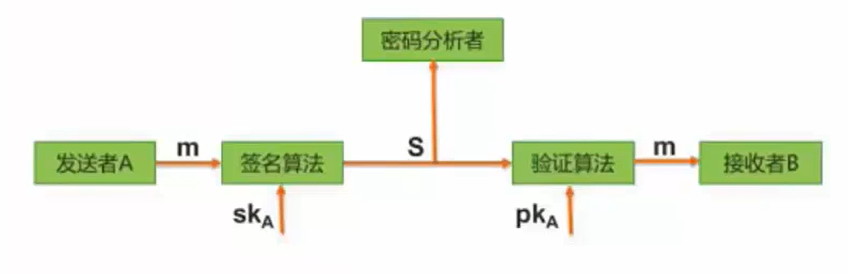

\quad 核心: 利用结构信息对 attention score 进行修正,这样在self-attention的基础上,比较好地利用上了图的结构信息。

\quad 动机: 目前图预测领域的主流算法是图神经网络(GNN)模型及其变种(比如图卷积网络(GCN,Graph Convolutional Net)、图注意力网络(GAT,Graph Attention Net)、图同构网络(GIN,Graph Isomorphic Net)等)。但是,这些图神经网络的结构相对简单,表达能力有限,且经常会出现过度平滑(Over-Smoothing)的问题(即无法通过堆深网络而增加 GNN 的表达能力)。相比于此,Transformer的模型表达能力很强,但是它的设计初衷是用来处理序列数据的,比如文本、语音等,并不能处理图结构数据。或者说self-attention机制只计算了节点的相关性,并没有考虑节点间的边信息(结构信息),self-attention机制将节点的相关性当作节点间的“边信息”,然而这并不包含结构关系。

\quad 那如何让Transformer处理图类型数据呢?对于这个问题,这篇文章认为核心在于如何让Transformer 学会编码图的结构信息。

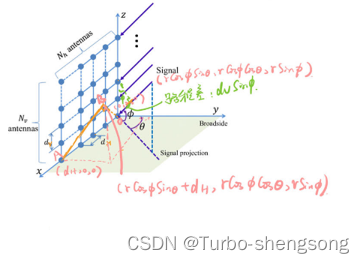

\quad Transformer 具有强大表达能力的原因在于其 自注意力机制,它通过计算输入中不同位置的语义信息相关性(可以理解为相似度),从而捕捉到输入之间的关系,并基于这些关系得到对整个输入完整的表达(representation)。然而,自注意力机制无法捕捉到结构信息,只能捕捉节点的相似度。对于自然语言序列而言,输入序列的结构信息可以简单认为是词与词的相对顺序,以及每个词在句子中的位置。对于图数据而言,这种结构信息更加复杂、多元,例如在图上的每个节点都有不同数量的邻居节点,两个节点之间可以有多种路径,每个边上都可能包含重要的信息。如何在图数据中成功应用 Transformer 的核心优势,最关键的难题是要确保Transformer可以正确利用图数据的结构信息。

\quad 为了在Transformer中引入图数据中的结构信息,这篇文章提出了 Graphormer 模型,引入了三种结构编码,以帮助 Transformer 模型捕捉图的结构信息。其实就是构造了这些结构编码,然后直接加到self-attention的注意力权重上,目的是为attention score引入结构信息来进行修正,从而令修正的注意力权重分配更准确。三种结构编码如下:(主要参考原作者的解释)

-

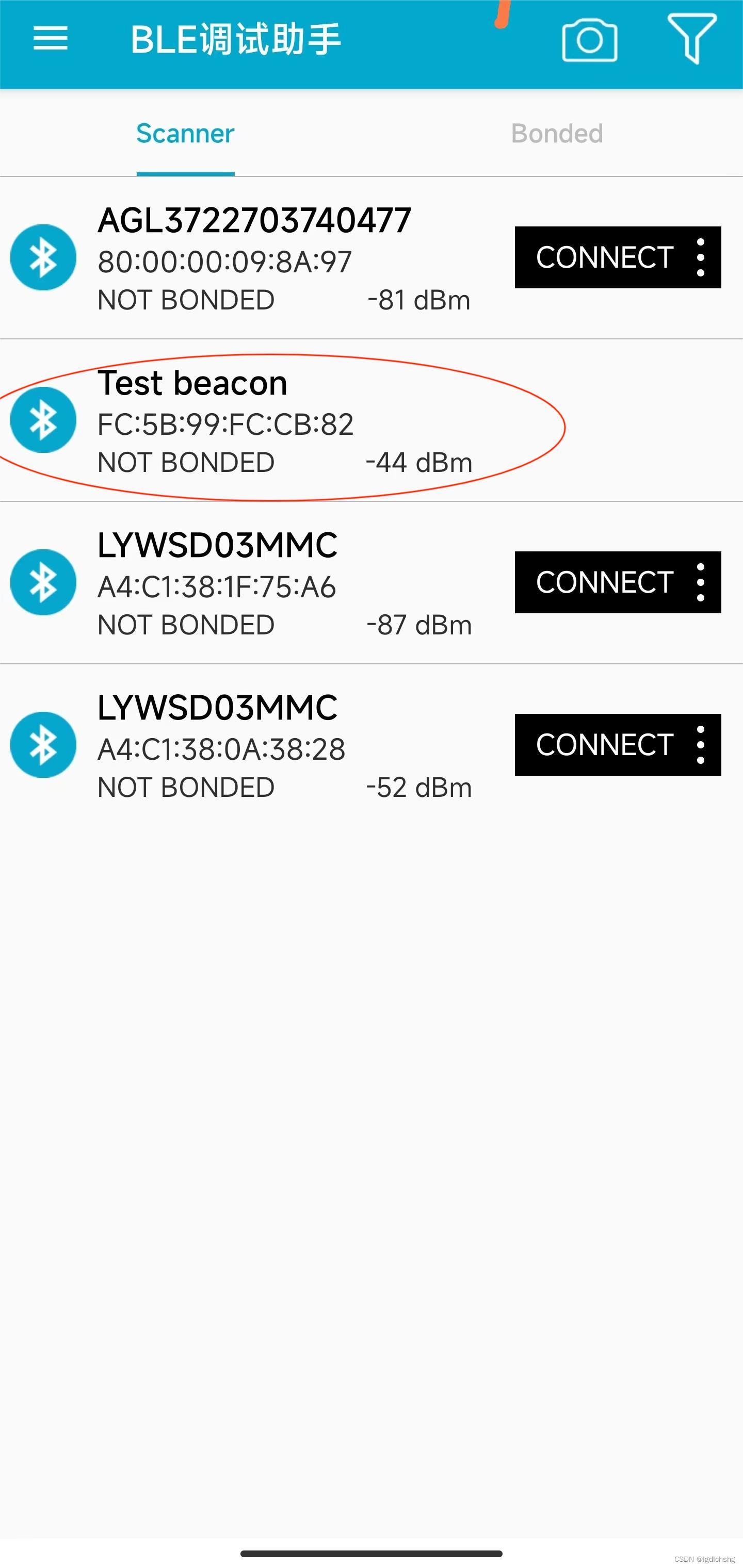

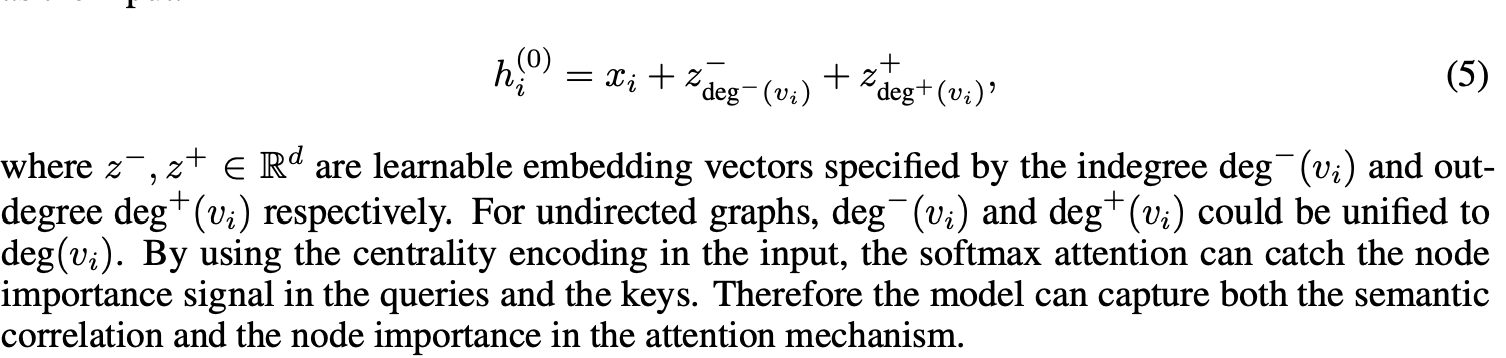

第一种编码,Centrality Encoding(中心性编码)。Centrality(中心性)是描述图中节点重要性的一个关键衡量指标。图的中心性有多种衡量方法,例如一个节点的“度”(degree)越大,代表这个节点与其他节点相连接的边越多,那么往往这样的节点就会更重要,如在疾病传播路线中的超级传播者,或社交网络上的大V、明星等。Centrality 还可以使用其他方法进行度量,如 Closeness、Betweenness、Page Rank 等。在 Graphormer 中,研究员们采用了最简单的度信息作为中心性编码,为模型引入节点重要性的信息。具体的方式是直接将Centrality Encoding加到每一个节点特征上。为什么要直接加到节点特征上?因为这些信息并没有反应注意力的信息,反映的是每个结点的特征。

- 其中

- 其中

-

第二种编码,Spatial Encoding(空间编码)。实际上图结构信息不仅包含了每个节点上的重要性,也包含了节点之间的重要性。例如:邻居节点或距离相近的节点之间往往相关性比距离较远的节点相关性高。因此,研究员们为 Graphormer 设计了空间编码:给定一个合理的距离度量 ϕ(vi,vj)ϕ(v_i, v_j)ϕ(vi,vj), 根据两个节点(vi,vj)(v_i, v_j)(vi,vj)之间的距离,为其分配相应的编码向量。距离度量 ϕ(⋅) 的选择多种多样,对于一般性的图数据可以选择无权或带权的最短路径,而对于特别的图数据则可以有针对性的选择距离度量,例如物流节点之间的最大流量,化学分子 3D 结构中原子之间的欧氏距离等等。为了不失一般性,Graphormer 在实验中采取了无权的最短路径作为空间编码的距离度量。具体实施时,在self-attention模块,在softmax之前,将两个点的shortest path作为一个bias term加到两个点的相关度上去。

其中:ϕ(vi,vj)ϕ(v_i, v_j)ϕ(vi,vj)是衡量节点间距离的一个函数,bϕ(vi,vj)b_{ϕ(v_i, v_j)}bϕ(vi,vj)为基于距离的一个可学习的标量 。无论在Graphormer的哪一层,图结构都是不变的,所以bϕ(vi,vj)b_{ϕ(v_i, v_j)}bϕ(vi,vj)在所有层中都是一样的,也就是共享。 -

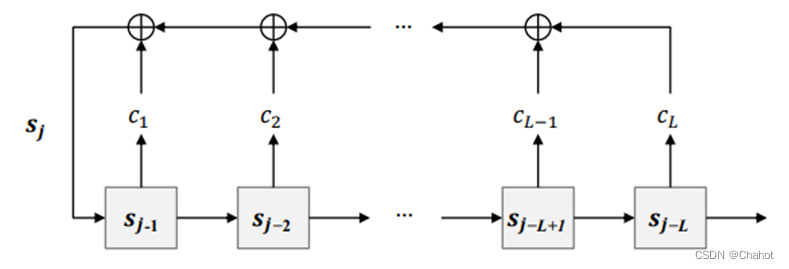

第三种编码,Edge Encoding(边信息编码)。对于很多的图任务,连边上的信息有非常重要的作用,例如连边上的距离、流量等等。然而为处理序列数据而设计的 Transformer 模型并不具备捕捉连边上的信息的能力,因为序列数据中并不存在“连边”的概念。因此,研究员们设计了edge encoding,将连边上的信息作为权重偏置(Bias)引入注意力机制中。具体来说,在计算两个节点之间的相关性时,研究员们对这两个节点最短路径SP上的连边特征进行加权求和作为注意力偏置,其中权重是可学习的。

其中:

\quad Graphormer采用最短路径的方式来进行边信息编码,因为它处理的还是一张图,是有邻接矩阵的。如果没有邻接矩阵,就是将所有的节点看作是一个全连接图,那么就无需最短路径了,因为每两个点之间的边就是最短路径。这类的Graph Transformer一般会将两两之间的“距离”当作边信息,那么此时,bϕ(vi,vj)b_{ϕ(v_i, v_j)}bϕ(vi,vj)和cijc_{ij}cij的作用就变成了一样的,都是将边信息纳入进attention score里。

\quad 《Language Conditioned Spatial Relation Reasoning for 3D Object Grounding》的思想在本质上有些与Graphormer类似,就是在self-attention的基础上加入了一种空间编码信息,相当于去除了edge、centrality encoding的Graphormer。

2.《Relational Attention: Generalizing Transformers for Graph-Structured Tasks》【ICLR2023-spotlight】

\quad 核心:为Transformer引入了节点间的有向边向量,并设计了一个Graph Transformer的计算方式,将QKV 向量 condition 到节点间的有向边。具体结构如下,细节参看之前文章:《Relational Attention: Generalizing Transformers for Graph-Structured Tasks》【ICLR2023-spotlight】

\quad 本文在效果上并没有与Graphormer直接对比,与Graphormer哪一个更好不能确定,应视具体任务而定。RT是将边向量直接加在q,k,v上,然后进行self-attention,最后得到的attention score中每一个元素如下式(11)所示。而Graphormer是将每一个边向量直接加在qk相乘后的attention score上,目的是对其做修正,最后得到的attention score为:niWnQ(njWnK)Tn_iW^Q_n(n_jW^K_n)^TniWnQ(njWnK)T(RT的attention score第一项)+ eije_{ij}eij。此外,Graphormer的v向量也没有加上边向量eije_{ij}eij。

\quad RT强调的是算法,对边向量 eije_{ij}eij 如何获取没有讨论。Graphormer强调的是将图数据的结构信息(≈RT中的边向量 eije_{ij}eij )纳入进Transformer中,主要考虑的是对边向量 eije_{ij}eij 如何构造(spatial encoding+edge encoding),在算法层面倒是很简单,直接加上attention score就行。

survey

TODO

![[ 应急响应基础篇 ] 使用 Autoruns 启动项分析工具分析启动项(附Autoruns安装教程)](https://img-blog.csdnimg.cn/6c995927a42a4e7f972f5914e33f2050.png)

![[PTA] 插松枝(C++,模拟)](https://img-blog.csdnimg.cn/31cf4bf1ef434d5d92ed1298d03a5212.png#pic_center)