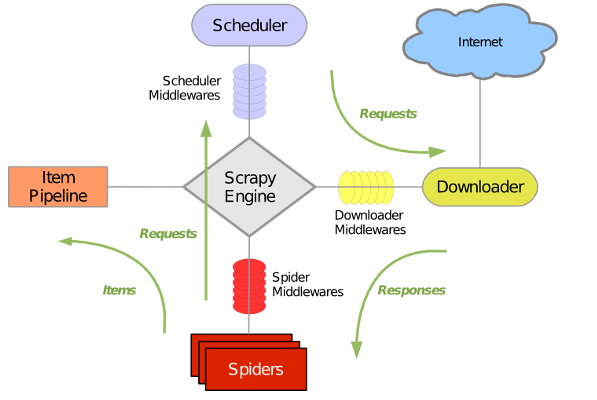

scrapy框架

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中。其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以应用在获取API所返回的数据(例如 Amazon Associates Web Services ) 或者通用的网络爬虫。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

-

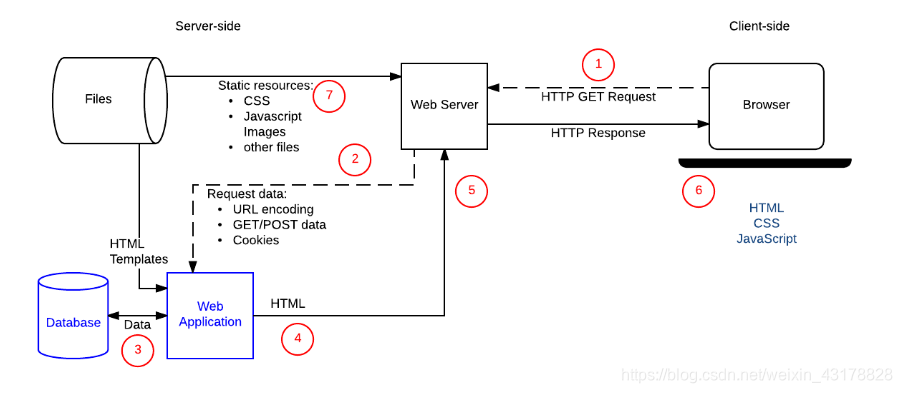

- 引擎(Scrapy)

用来处理整个系统的数据流, 触发事务(框架核心) - 调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址 - 下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的) - 爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面 - 项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被发送到项目管道,并经过几个特定的次序处理数据。 - 下载器中间件(Downloader Middlewares)

位于Scrapy引擎和下载器之间的框架,主要是处理Scrapy引擎与下载器之间的请求及响应。 - 爬虫中间件(Spider Middlewares)

介于Scrapy引擎和爬虫之间的框架,主要工作是处理蜘蛛的响应输入和请求输出。 - 调度中间件(Scheduler Middewares)

介于Scrapy引擎和调度之间的中间件,从Scrapy引擎发送到调度的请求和响应。

- 引擎(Scrapy)

1.新建scrapy项目

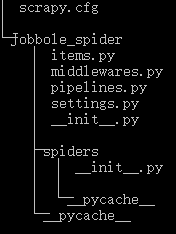

scrapy startproject Jobbole_spider2.文件结构

- scrapy.cfg 项目的配置信息,主要为Scrapy命令行工具提供一个基础的配置信息。(真正爬虫相关的配置信息在settings.py文件中)

- items.py 设置数据存储模板,用于结构化数据,如:Django的Model

- pipelines 数据处理行为,如:一般结构化的数据持久化

- settings.py 配置文件,如:递归的层数、并发数,延迟下载等

- spiders 爬虫目录,如:创建文件,编写爬虫规则

- middlewares 中间件,可以编写下载器中间件和爬虫中间件 如:动态设置代理IP、随机更换user-agent

3.设置数据存储模板

items.py

class JobboleSpiderItem(scrapy.Item):title = scrapy.Field() # Field任何类型create_date = scrapy.Field()url = scrapy.Field()url_object_id = scrapy.Field()praise_nums = scrapy.Field()comment_nums = scrapy.Field()fav_nums = scrapy.Field()tags = scrapy.Field()content = scrapy.Field()4.编写爬虫文件

jobbole.py

class Jobbole_spider(scrapy.Spider):name = "jobbole"allowed_domains = ["blog.jobbole.com"]start_urls = ['http://blog.jobbole.com/all-posts/']def parse(self, response):"""1.获取文章列表页中的文章url并交给scrapy下载并进行解析2.获取下一页的url并交给scrapy下载 下载完成后交给parse"""# 解析列表页中所有文章的urltime.sleep(random.random()*3)post_nodes = response.xpath("//div[@class='post floated-thumb']/div[1]/a")for post_node in post_nodes:post_url = post_node.xpath('./@href').extract()[0]yield Request(url=parse.urljoin(response.url, post_url), callback=self.parse_detail)# 提交下一页并交给 scrapy 进行下载next_url = response.xpath("//a[@class ='next page-numbers']/@href").extract()[0]if next_url:yield Request(url=parse.urljoin(response.url, next_url), callback=self.parse)def parse_detail(self, response):item = JobboleSpiderItem()# 提取文章具体字段title = response.xpath('//div[@class="entry-header"]/h1/text()').extract_first("") # extract_first()不需要考虑空值的异常处理create_date = response.xpath("//p[@class='entry-meta-hide-on-mobile']/text()").extract()[0].strip().replace("·","").strip()praise_nums = response.xpath("//span[contains(@class, 'vote-post-up')]/h10/text()").extract()[0]fav_nums = response.xpath("//span[contains(@class, 'bookmark-btn')]/text()").extract()[0]match_re = re.match(".*?(\d+).*", fav_nums)if match_re:fav_nums = int(match_re.group(1))else:fav_nums = 0 # 没有取到数字给默认值comment_nums = response.xpath("//a[@href='#article-comment']/span/text()").extract()[0]match_re = re.match(".*?(\d+).*", comment_nums)if match_re:comment_nums = int(match_re.group(1))else:comment_nums = 0content = response.xpath("//div[@class='entry']").extract()[0]tag_list = response.xpath("//p[@class='entry-meta-hide-on-mobile']/a/text()").extract()tag_list = [element for element in tag_list if not element.strip().endswith("评论")]tags = ",".join(tag_list)item["title"] = titletry:create_date = datetime.datetime.strptime(create_date, "%Y/%m/%d").date()except Exception as e:create_date = datetime.datetime.now().date()item["create_date"] = create_dateitem["url"] = response.urlitem["url_object_id"] = get_md5(response.url)item["praise_nums"] = praise_numsitem["comment_nums"] = comment_numsitem["fav_nums"] = fav_numsitem["tags"] = tagsitem["content"] = contentyield itemtip:在写xpath解析时,可以用scrapy提供一种shell模式来检验xpath语法是否正确

如:

scrapy shell http://blog.jobbole.com/114706/

5.编写pipeline保存

写入json文件

class JsonWithEncodingPipeline(object):def __init__(self):self.file = codecs.open('jobbole.json', 'w', encoding="utf-8")def process_item(self, item, spider):lines = json.dumps(dict(item), ensure_ascii=False) + "\n"self.file.write(lines)return itemdef spider_closed(self, spider):self.file.close()写入mysql数据库

class MysqlPipeline(object):# 采用同步的机制写入mysqldef __init__(self):self.conn = MySQLdb.connect('127.0.0.1', 'username', 'password', 'dbname', charset="utf8", use_unicode=True)self.cursor = self.conn.cursor()def process_item(self, item, spider):insert_sql = """insert into jobbole_spider(title,create_date,url,url_object_id,praise_nums,comment_nums,fav_nums,tags,content)VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s)"""self.cursor.execute(insert_sql, (item["title"], item["create_date"],item["url"], item["url_object_id"],item["praise_nums"], item["comment_nums"],item["fav_nums"], item["tags"], item["content"]))self.conn.commit()6.配置settings文件

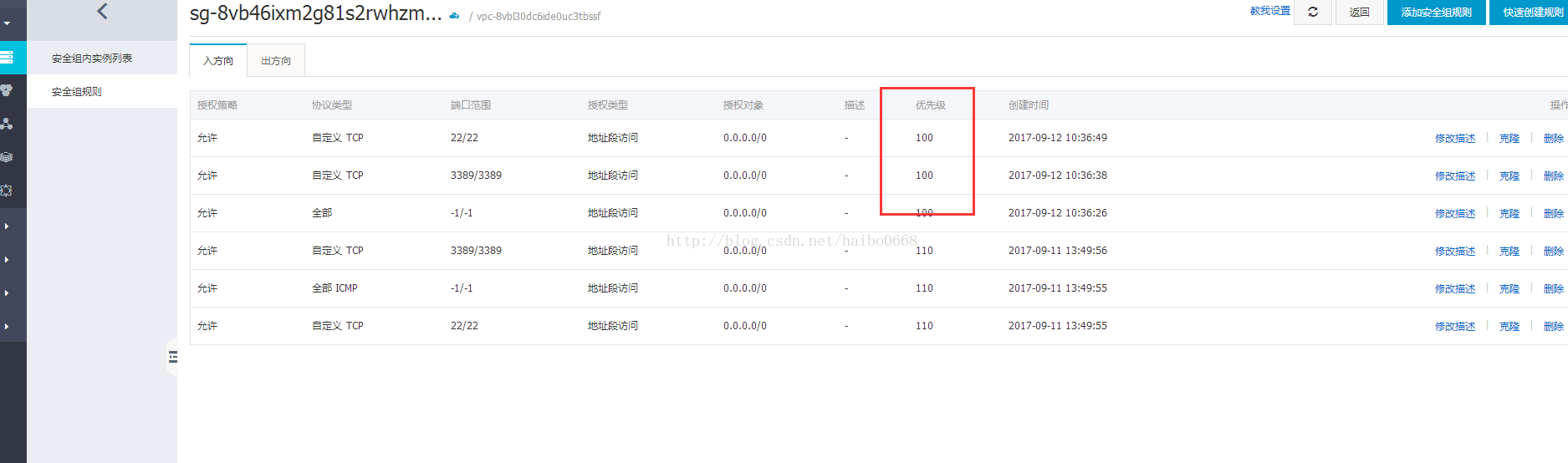

ITEM_PIPELINES = {'Jobbole_spider.pipelines.MysqlPipeline': 200,'Jobbole_spider.pipelines.JsonWithEncodingPipeline': 100,

}每个pipeline后面有一个数值,这个数组的范围是0-1000,这个数值确定了他们的运行顺序,数字越小越优先

另外在settings.py文件中设置

ROBOTSTXT_OBEY = False如果不设置,scrapy默认读取每一个网站的ROBOTS协议,把不符合ROBOTS协议的url过滤掉

7.main文件运行爬虫

sys.path.append(os.path.dirname(os.path.abspath(__file__)))

cmdline.execute("scrapy crawl jobbole".split())