前面的内容,我们了解了使用urllib3和selenium来下载网页,但下载下来的是整个网页的内容,那我们又怎么从下载下来的网页中提取我们自己感兴趣的内容呢?这里就需要Python的另一个库来实现-BeautifulSoup。

BeautifulSoup 是一个 Python 库,用于分析 HTML。它和它的名字一样,用起来非常“香”。今天我们通过使用 BeautifulSoup 去从上一篇文章案例中下载到的 html 文件:jiandan.html 中提取所有新闻的标题。

打开 VS Code,并创建ipynb文件,将之前下载的jandan.html文件复制到源文件共同的文件夹内。

接下来我们将在这个 notebook 中对 jiandan.html 进行内容提取。

1、安装BeautifulSoup

这里安装的步骤和之前安装selenium的步骤一样。

我们去开始菜单 → Anaconda ,选择 Anaconda Prompt,出现命令行界面。在命令行界面,输入如下安装命令:(BeautifulSoup 的 Python 包名为 bs4, 简写)

conda install bs4

回车执行,之后在询问会否确认时输入 y 回车,等待安装完毕,关闭即可。

(1)读取html文件到Python

数据提取的第一步,我们首先需要将 html 文件加载到 Python 的变量中。在上一篇文章中,我们了解了通过文件对象来把 Python 变量写进文件里,这里我们来尝试用类似的代码来将文件中的内容读出来。

代码如下,可以看到和写入文件的代码非常类似。

# 打开 jiandan.html,第二个参数 r,代表 read# open 函数返回一个文件对象,保存在变量 fo 中fo = open("jiandan.html","r",encoding="utf-8")# 调用文件对象的 read 函数,该函数将文件的内容读取到 Python 中# read 函数的返回值就会文件内容,我们保存在 html_content 中html_content = fo.read()# 关闭文件对象fo.close()# 打印 html_content 变量,看内容是否被正确加载print(html_content)执行之后,输出结果如下所示(打印的 html 文本太长,这里仅截图示意)。

(2)创建BeautifulSoup对象

现在,我们已经将文件的内容读了出来,但是目前还是以一个超大的字符串的形式存储在变量中。想要对其进行有效的分析,第一步我们先要构造一个 BeautifulSoup 的对象。代码如下:

# 从 bs4 模块中导入 BeautifulSoup 类from bs4 import BeautifulSoup# 创建一个 BeautifulSoup 的对象,并将刚才我们存储网页内容的变量作为参数doc = BeautifulSoup(html_content)# 打印 doc 对象的 title 属性。print(doc.title)执行上述代码之后,BeautifulSoup 对象就被创建并存在变量 doc 中,为了测试是否创建成功,我们打印了 doc 对象的 title 属性,输出如下。

<title>煎蛋 - 地球上没有新鲜事</title>(3)BeautifulSoup 对象的基本使用

刚刚我们打印了 doc 对象的 title 属性,来测试对象是否创建成功。从打印的内容来看,想必你已经猜到了,doc 对象的 title 属性,就对应了网页的 title 标签。但是刚才我们打印的内容中,title 标签也被打印出来了。

那是否可以只取标签里面的内容呢?

①get_text方法

在 BeautifulSoup 中,我们可以通过标签对象的 get_text 方法来获得标签中的内容。

# 将 title 属性保存在 title_label 的变量中title_label = doc.title# 调用 get_text 方法,并把返回值打印出来print(title_label.get_text())输出如下:

煎蛋 - 地球上没有新鲜事可以看到,这次我们成功将标签内的文字提取了出来。

②find_all方法

BeautifulSoup 对象另一个常用方法是 find_all, 用来在 html 文档中查到特定标签名以及特定属性值的标签,下面来举例说明。

比如,在网页上有这么个结构

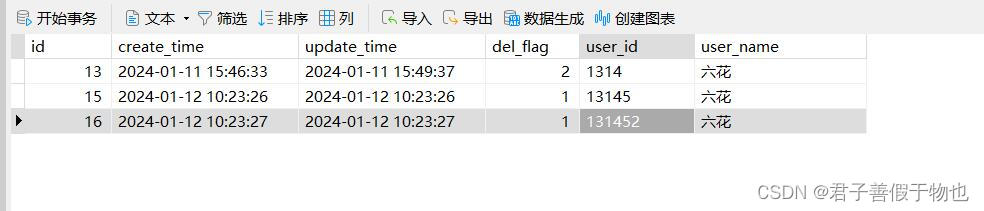

目前我们的 doc 对象已经包含了这些内容。现在我们来尝试提取 class 等于 logo 的这个 div 标签,代码如下。

# find_all 是 BeautifulSoup 对象的常用方法,用于查找特定的标签# 接受三个参数,第一个是要查找的标签名,第二个则是要匹配的属性名# 比如这里,我们查找的是 class=logo 标签,则直接按如下写法即可。# 因为 class 是 Python 的关键字,所以这里需要使用 class_ 以示区分# 最终,find_all 函数返回所有满足条件的标签列表logo_label = doc.find_all("div", class_="logo")print(logo_label)输出结果为:

[<div class="logo"><h1><a href="/" onclick="ga('send', 'pageview','/header/logo');">煎蛋</a></h1></div>]可以看到,我们截图中的内容,箭头所指的 div 标签被成功的过滤了出来。

③获取标签对象的属性

通过标签对象的 attrs 属性,我们可以获取标签对象的属性的值,attrs 是一个字典,获取属性的值的方法如下:

# 取 logo_label 列表的第一个标签对象label = logo_label[0]# 打印这个对象的 class 属性print(label.attrs["class"])输出:

['logo']2、过滤出网页的新闻列表

现在,我们来使用之前的 doc 对象来过滤出新闻的标题列表。

(1)观察html,提取初步的新闻标签列表

在使用 BeautifulSoup 进行内容过滤的第一步,首先要查看我们想要的内容所在的标签。我们在 VS Code 中打开 jiandan.html,搜索“普通感冒”到达新闻标题内容区域,如下图所示。

通过观察截图中的标签内容,很容易发现似乎每个新闻标题,都有一个对应的 div 标签,并且它的 class 是 indexs。沿着这个思路,我们可以先考虑使用 find_all 将其过滤出来。通过如下代码。

# 查找 class 为 indexs 的所有 div 标签,存储在 index_labels 中index_labels = doc.find_all("div", class_="indexs")# 打印符合条件的 div 标签的数量print(len(index_labels))输出:

24

说明找到了 24 个符合条件的 div 标签。一个网页的新闻也是 20 多条,说明有希望。

(2)提取单个标签的新闻标题

因为 index_labels 是一个标签对象的列表,距离我们要过滤的新闻标题还有距离。下一步,我们就来分析如何从这些标签对象中抽取新闻标题。

首先,我们先取第一个来看一下。

first_object = index_labels[0]print(first_object)输出如下:

<div class="indexs"><span class="comment-link" title="1小时 ago">8</span><h2><a href="http://jandan.net/p/108693" target="_blank">引发普通感冒的鼻病毒会将新冠病毒排挤出细胞!</a></h2><div class="time_s"><a href="http://jandan.net/p/author/majer">majer</a> · <strong><a href="http://jandan.net/p/tag/%e6%96%b0%e5%86%a0%e7%97%85%e6%af%92" rel="tag">新冠病毒</a></strong></div>换而言之,如果你感冒了,在那段期间就不会被新冠病毒感染 </div>现在我们的问题就转化为,如何从上述 html 中抽取出新闻的标题。

通过查看上述内容可以发现,我们的标题在第三行,在一个 a 标签内部。那是不是我们只需要过滤出这个 a 标签,再使用 get_text 拿到里面的内容就好了?

那要怎么过滤出第三行的 a 标签呢?可以看到这个 a 标签里有 target=“_blank” 这样一个属性,我们就可以使用 find_all 将其过滤出来了。

# 从刚才的 first_object 标签对象中过滤出所有 target=_blank 的 a 标签a_labels = first_object.find_all("a",target="_blank")# 取第一个标签对象my_label = a_labels[0]# 打印该标签对象内的文字内容print(my_label.get_text())输出如下:

引发普通感冒的鼻病毒会将新冠病毒排挤出细胞!你看,新闻的标题被成功抽取了出来!

(3)提取新闻标题的列表

目前,我们已经实现了从第一个标签对象中提取新闻标题,但我们的列表中有 24 个标签对象。要怎么做呢?聪明的你应该想到了,我们只需要把“从标签对象抽取标题”这段逻辑写成一个函数,然后通过一个循环对列表的每个标签对象都调用这个函数即可。

# 从第一次 find_all 获取的标签对象中抽取标题def get_title(label_object):# 从刚才的参数传入的标签对象中过滤出所有 target=_blank 的 a 标签a_labels = label_object.find_all("a",target="_blank")# 取第一个标签对象my_label = a_labels[0]# 将标签的文字内容作为返回值返回return my_label.get_text()# 用循环针对每个 index_labels 列表中的标签对象# 都将其作为参数传入 get_title 函数# 并打印返回值for i in range(0,len(index_labels)):title = get_title(index_labels[i])print(title)执行后输出:

引发普通感冒的鼻病毒会将新冠病毒排挤出细胞!无厘头研究:植入虚假的记忆再抹去它们什么是仇恨犯罪?突发:LHCb发现了违背标准模型的现象今日带货 20210324舌战裸猿:IBM搞出了可以打辩论赛的AI大吐槽:「我没醉,醉的是世界」今年世界总发电量的0.6%被用于挖比特币接种疫苗后还是感染新冠?不要为此惊讶今日带货:蛋友家的血橙科学家首次在野外检测到抗多药的超级真菌未在iPhone12盒中搭配充电器,苹果被巴西消协罚200万美元工程师将解决城市陷坑的问题今日带货:粉面专场科学家在碟子里培育出了泪腺,并让它哭泣疯狂实验进行时:把志愿者禁闭在黑暗的空间里40天今日带货 20210321我们已向外星人发送了哪些消息?脑力小体操:石头+剪刀 VS 石头+布发霉啦:今天,我终于向母亲摊牌了普渡大学的经济学家计算出世界各地幸福的价格人类首次观察到木星上极光黎明风暴的成形过程为女儿出头,母亲编辑假裸照败坏高中啦啦队队员的名誉今日带货:淘宝京东蛋友推荐可以看到,jiandan.html 中的所有新闻标题被我们成功过滤了出来,现在是不是感受到了 BeautifulSoup 的神奇之处了呢。

至此,我们就完成了使用 BeautifulSoup 对网页进行内容的提取。