网站运营人员对于死链这个概念一定不陌生,网站的一些数据删除或页面改版等都容易制造死链,影响用户体验不说,过多的死链还会影响到网站的整体权重或排名。

百度站长平台提供的死链提交工具,可将网站存在的死链(协议死链、404页面)进行提交,可快速删除死链,帮助网站SEO优化。在提交死链的文件中逐个手动填写死链的话太麻烦,工作中我们提倡复杂自动化,所以本文我们一起交流分享Apache服务中通过shell脚本整理网站死链,便于我们提交。

1.配置Apache记录搜索引擎

Apache是目前网站建设最为主流的web服务,但是apache的日志文件默认是不记录百度、谷歌等各大搜索引擎的爬取程序的,所以首先需要我们设置Apache的配置文件。

找到Apache的配置文件httpd.conf,在配置文件中找到下面两行:

CustomLog "logs/access_log" common#CustomLog "logs/access_log" combined

默认采用的是common,这里我们只需要将common这一行前面加#注释掉,然后将combined这一行前的#去掉即可。然后保存重启Apache服务。

注:如果你的服务器上添加了多个站点,每个站点有单独的配置文件,则我们只需要在相应站点的配置文件中设置CustomLog项即可,例如:

vim /usr/local/apache/conf/vhost/www.chanzhi.org.confServerAdmin [email protected] DocumentRoot "/data/wwwroot/www.chanzhi.org"ServerName www.chanzhi.orgServerAlias chanzhi.orgErrorLog "/data/wwwlogs/www.chanzhi.org_error_apache.log"CustomLog "/data/wwwlogs/www.chanzhi.org_apache.log" combinedSetOutputFilter DEFLATEOptions FollowSymLinks ExecCGIRequire all grantedAllowOverride AllOrder allow,denyAllow from allDirectoryIndex index.html index.php

下面是配置前后的网站日志记录格式:

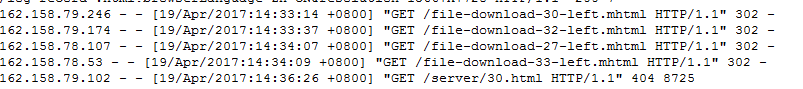

配置前:

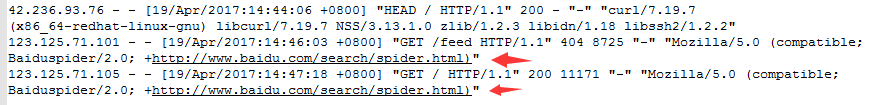

配置后:

2.编写shell脚本

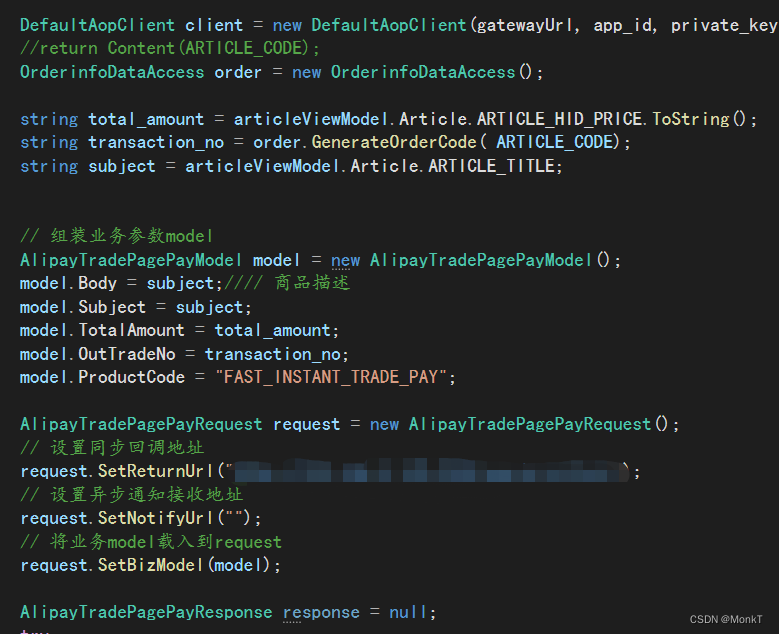

我们通过shell脚本获取网站日志中指定爬虫的抓取记录,然后汇总到一个文件中,便于后期使用。代码如下,比如保存为deathlink.sh

1 #!/bin/bash 2 #初始化变量 3 #定义蜘蛛UA信息(默认是百度蜘蛛) 4 UA='+http://www.baidu.com/search/spider.html' 5 6 #前一天的日期(apache日志) 7 DATE=`date +%Y%m%d -d "1 day ago"` 8 9 #定义日志路径 10 logfile=/data/wwwlogs/www.chanzhi.org_apache.log-${DATE}.log 11 12 #定义死链文件存放路径 13 deathfile=/data/wwwroot/www.chanzhi.org/deathlink.txt 14 15 #定义网站访问地址 16 website=http://www.chanzhi.org 17 18 #分析日志并保存死链数据 19 for url in `awk -v str="${UA}" '$9=="404" && $15~str {print $7}' ${logfile}` 20 do 21 grep -q "$url" ${deathfile} || echo ${website}${url} >>${deathfile} 22 done

大家在使用该脚本时,根据自己服务器情况调整下路径和字段即可,然后执行脚本,:

bash deathlink.sh

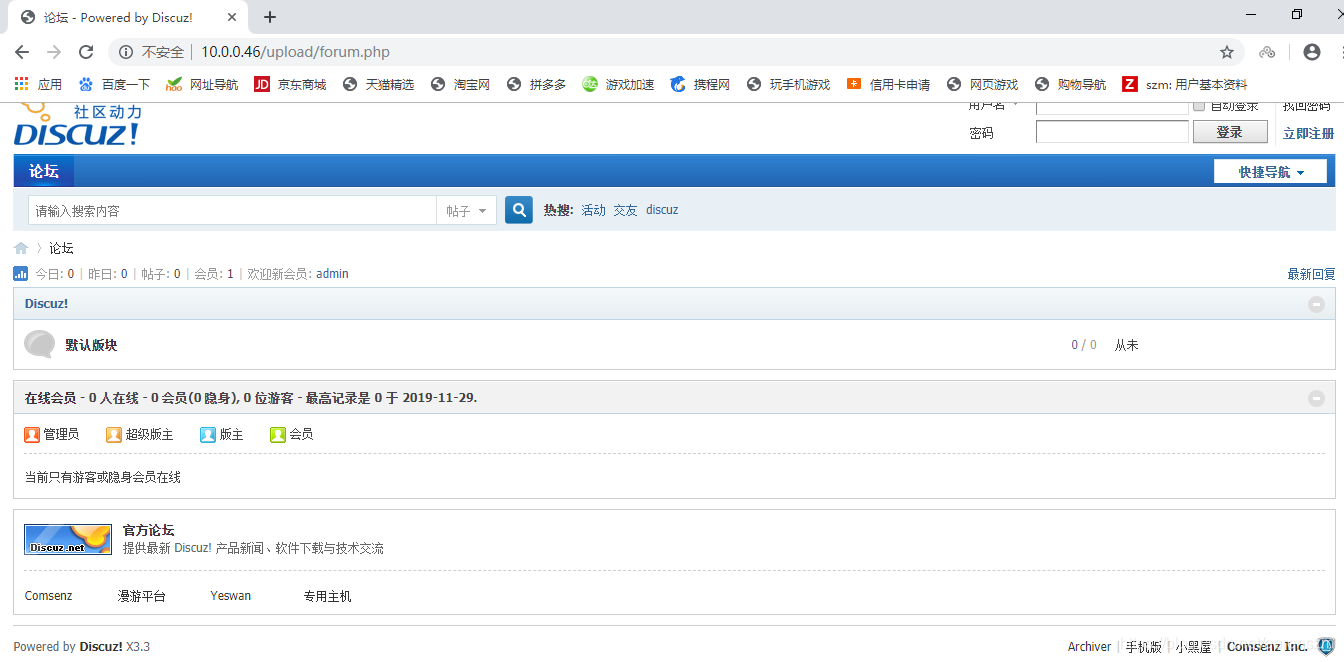

3.提交死链

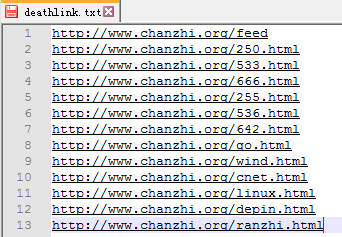

执行上面脚本时候,就会在指定目录下生成包含所有获取的404页面链接的文件,每个连接占一行。例如:

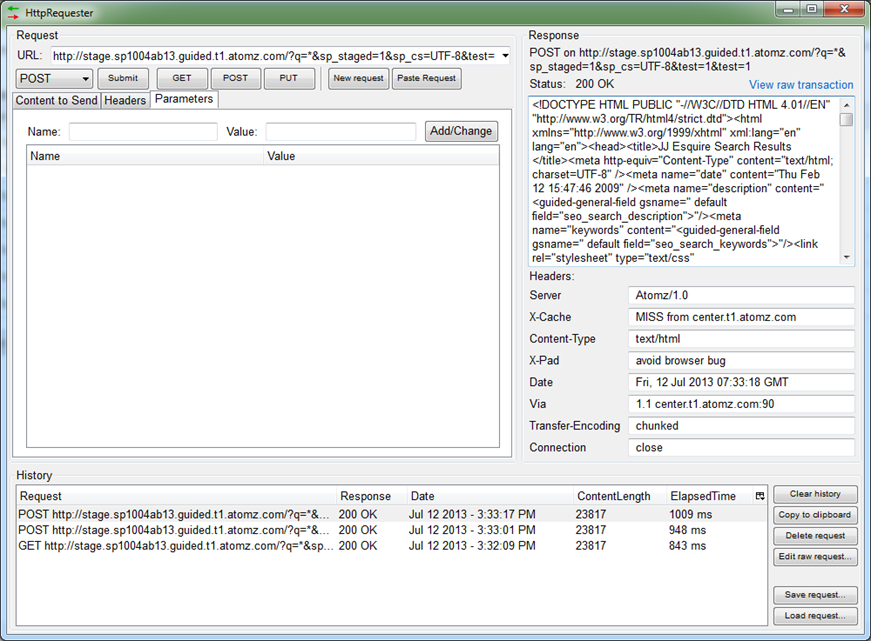

最后在站长平台提交死链页面中,填写自己的死链文件地址即可,例如:

百度在审核通过之后,会将已经收录的失效链接删除,以避免失效页面链接对网站造成不良的影响。

总结:

本文和大家分享了在Apache服务环境下,如何利用shell脚本自动获取百度蜘蛛等爬虫抓取的死链,并生成汇总文件提交给搜索引擎。如果大家还有其他更好的方法或者疑问,欢迎一起分享交流。