5.1 如何使用窗口函数

回顾:

窗口函数格式:分析函数 over(partition by xxx order by xxx [asc|desc] [rows between xxx and xxx])学习的相关分析函数有那些? 第一类: row_number() rank() dense_rank() ntile()第二类: 和聚合函数组合使用 sum() avg() max() min() count()第三类: lag() lead() first_value() last_value()

如何在Spark SQL中使用呢?

- SQL中: 与HIVE中应用基本没啥区别, 更多关注的是DSL写法

from pyspark import SparkContext, SparkConf

from pyspark.sql import SparkSession

import pyspark.sql.functions as F

from pyspark.sql import Window as win

import os# 锁定远端环境, 确保环境统一

os.environ['SPARK_HOME'] = '/export/server/spark'

os.environ['PYSPARK_PYTHON'] = '/root/anaconda3/bin/python3'

os.environ['PYSPARK_DRIVER_PYTHON'] = '/root/anaconda3/bin/python3'if __name__ == '__main__':print("演示: 如何在Spark SQL中使用窗口函数...")# 1- 创建SparkSession对象spark = SparkSession.builder.appName('df_write').master('local[*]').getOrCreate()# 2-读取外部文件的数据df = spark.read.csv(path='file:///export/data/workspace/ky06_pyspark/_03_SparkSql/data/pv.csv',header=True,inferSchema=True)df.createTempView('t1')# 3- 执行相关的操作# 需要: 统计每个cookie中, pv数量排名前二内容是哪些? (分组TOPN 问题)# SQLspark.sql("""with t2 as(select*,row_number() over (partition by cookieid order by pv desc) as rank1from t1 )select * from t2 where rank1 <=2""").show()# DSL:df.select('*',F.row_number().over(win.partitionBy('cookieid').orderBy(F.desc('pv'))).alias('rank1')).where('rank1 <= 2').show()

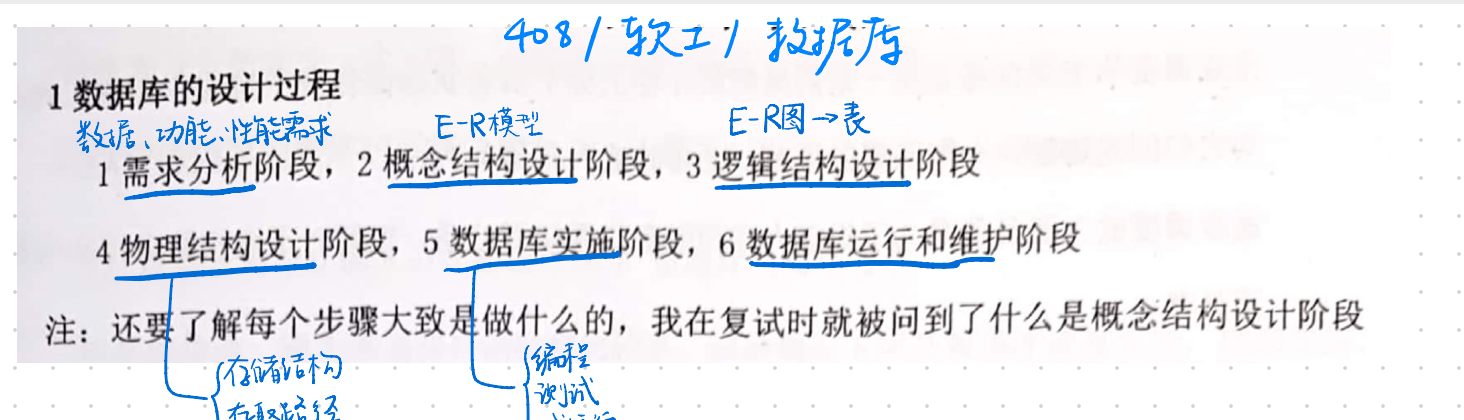

2 SQL函数的分类说明

整个SQL函数, 主要是分为以下三大类:

- UDF函数: 用户自定义函数

- 表示: 一进一出

- 整个函数中, 大多数的函数都是属于一进一出的函数: split() substr()

- UDAF函数: 用户自定义聚合函数

- 表示: 多进一出

- 例如: sum() avg() count() ….

- UDTF函数: 用户自定义表生成函数

- 表示: 一进多出

- 指的: 进去一行数据, 最终产生多行 或者多列的数据

- 例如: explode

在SQL中提供的内置函数, 都是属于以上三类中某一类函数

思考: 提供了那么多的函数, 为啥还需要自定义函数呢?

扩充函数. 在实际使用中, 并不能保证所有的操作可能用的函数都已经提前的内置好, 尤其是很多具有特殊业务处理功能, 其实并没有相对应函数 , 提供的函数更多是以公共的功能为主函数, 此时需要进行自定义, 从而扩充新的功能

在Spark SQL中, 对于自定义函数, 原生支持的粒度并不是特别好, 目前原生的PY方案仅支持自定义UDF函数, 无法自定义UDAF函数和UDTF函数, 在1.6版本之后, Java 和scala语言支持了自定义UDAF函数,但是Python并不支持,Spark官方提供了解决的方案: 基于pandas来自定义UDF 和 UDAF函数. 但是对于UDTF函数, Spark是不支持自定义,但是Spark支持HIVE的函数定义, 所以可以通过HIVE自定义函数来解决

虽然Python支持自定义UDF函数, 但是其效率并不是特别的高效, 因为在使用的时候, 传递一行处理一行, 返回一行的操作, 这样会带来非常大的序列化开销问题, 以及网络开销问题, 导致原生UDF函数效率不好早期解决方案: 基于 scala/Java来编写自定义UDF函数, 然后基于Python使用即可目前主要解决方案: 引入Arrow框架, 可以基于内存来完成数据传输工作, 可以大大降低了序列化开销问题, 提供传输的效率, 解决了原生问题, 同时还可以基于pandas的自定义函数, 利用pandas函数优势, 完成各种处理操作所以后期主推的方案: 基于pandas 自定义函数, 然后底层基于arrow完成数据传输工作

3 Spark SQL原生自定义函数

如何自定义原生函数流程(非常重要):

第一步: 在Python中创建一个python的函数, 在这个函数中书写自定义函数的功能逻辑代码即可第二步: 将Python函数注册到Spark SQL中, 成为Spark SQL的函数注册方式一: udf对象 = sparkSession.udf.register(参数1,参数2,参数3)参数1: UDF函数的名称, 此名称用于后续在SQL语法中使用 , 可以任意定义名称, 但是要符合定义名称规范参数2: python函数的名称, 表示将哪个python的函数注册为Spark SQL的函数参数3: 返回值的类型, 用于表示当前这个Python的函数返回的类型对应的Spark SQL的数据类型udf对象: 此对象主要是用于DSL中注册方式二: udf对象 = F.udf(参数1,参数2)参数1: python函数的名称, 表示将哪个python的函数注册为Spark SQL的函数参数2: 返回值的类型, 用于表示当前这个Python的函数返回的类型对应的Spark SQL的数据类型udf对象: 此对象主要是用于DSL中说明: 此种方式还支持语法糖写法: @F.udf(returnType=返回值类型) 需要放置到对应函数上面

第三步: 在Spark SQL的DSL/SQL中进行使用即可

演示操作: 请自定义一个函数, 完成对数据统一添加一个后缀名的操作

from pyspark import SparkContext, SparkConf

from pyspark.sql import SparkSession

from pyspark.sql.types import *

import pyspark.sql.functions as F

import os# 锁定远端环境, 确保环境统一

os.environ['SPARK_HOME'] = '/export/server/spark'

os.environ['PYSPARK_PYTHON'] = '/root/anaconda3/bin/python3'

os.environ['PYSPARK_DRIVER_PYTHON'] = '/root/anaconda3/bin/python3'if __name__ == '__main__':print("演示原生的自定义函数:")# 1- 创建SparkSession对象spark = SparkSession.builder.appName('df_write').master('local[*]').getOrCreate()# 2- 初始化一些数据df = spark.createDataFrame(data=[(1,'张三','北京'),(2,'李四','上海'),(3,'王五','广州'),(4,'赵六','深圳'),(5,'田七','杭州')],schema='id int,name string,address string')df.createTempView('t1')# 3- 执行相关的操作:# 请自定义一个函数, 完成对数据统一添加一个后缀名的操作# 3.1 定义一个Python的函数, 接收一个数据, 给数据添加一个后缀返回@F.udf(returnType=StringType())def add_post(data):return data+'_boxuegu'# 3.2 对函数进行注册操作# 注册方式一# 当采用注解方式注册函数的使用, 如果依然想在SQL中使用, 可以再次使用方式一注册,但是不需要设置返回值类型了spark.udf.register('add_post_sql',add_post)# 注册方式二: 还有一种语法糖模式#add_post_dsl = F.udf(add_post,StringType())# 3.3 使用自定义函数# SQLspark.sql("""select*,add_post_sql(address) as r1from t1""").show()# DSLdf.select('*',add_post('address').alias('r1')).show()

演示操作: 自定义一个函数, 让其返回值的类型为字典 列表 元组

from pyspark import SparkContext, SparkConf

from pyspark.sql import SparkSession

from pyspark.sql.types import *

import pyspark.sql.functions as F

import os# 锁定远端环境, 确保环境统一

os.environ['SPARK_HOME'] = '/export/server/spark'

os.environ['PYSPARK_PYTHON'] = '/root/anaconda3/bin/python3'

os.environ['PYSPARK_DRIVER_PYTHON'] = '/root/anaconda3/bin/python3'if __name__ == '__main__':print("演示原生的自定义函数:")# 1- 创建SparkSession对象spark = SparkSession.builder.appName('df_write').master('local[*]').getOrCreate()# 2- 初始化一些数据df = spark.createDataFrame(data=[(1,'张三 北京'),(2,'李四 上海'),(3,'王五 广州'),(4,'赵六 深圳'),(5,'田七 杭州')],schema='id int,name_address string')df.createTempView('t1')# 3- 执行相关的操作:# 需求: 自定义一个函数, 将姓名和地址拆分开schema = StructType().add('name',StringType()).add('address',StringType())@F.udf(returnType=schema)def split_data(data):res = data.split(' ')#return [res[0],res[1]]#return (res[0], res[1])return {'name':res[0],'address':res[1]}# 使用字典返回, key值 必须和schema中定义字段名称保持一致# 注册函数spark.udf.register('split_data',split_data)# 使用函数# SQLdf1 = spark.sql("""select*,split_data(name_address)['name'] as name,split_data(name_address)['address'] as addressfrom t1""")df1.printSchema()df1.show()# DSLdf.select('*',split_data('name_address')['name'].alias('name'),split_data('name_address')['address'].alias('address')).show()