整理:AI算法与图像处理

CVPR2023论文和代码整理:https://github.com/DWCTOD/CVPR2023-Papers-with-Code-Demo

欢迎关注公众号 AI算法与图像处理,获取更多干货:

大家好, 最近正在优化每周分享的CVPR论文, 目前考虑按照不同类别去分类,方便不同方向的小伙伴挑选自己感兴趣的论文哈

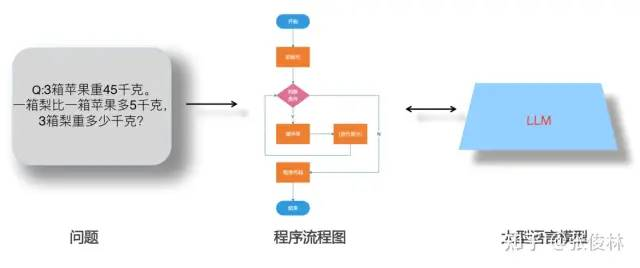

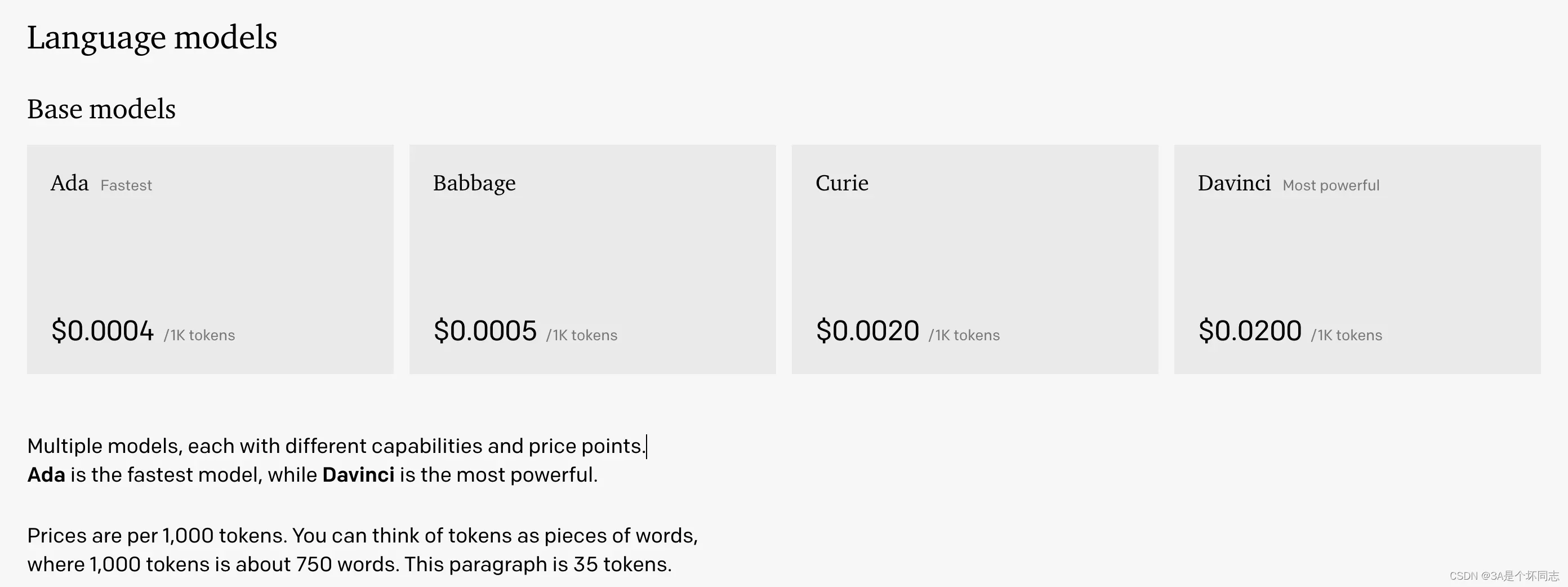

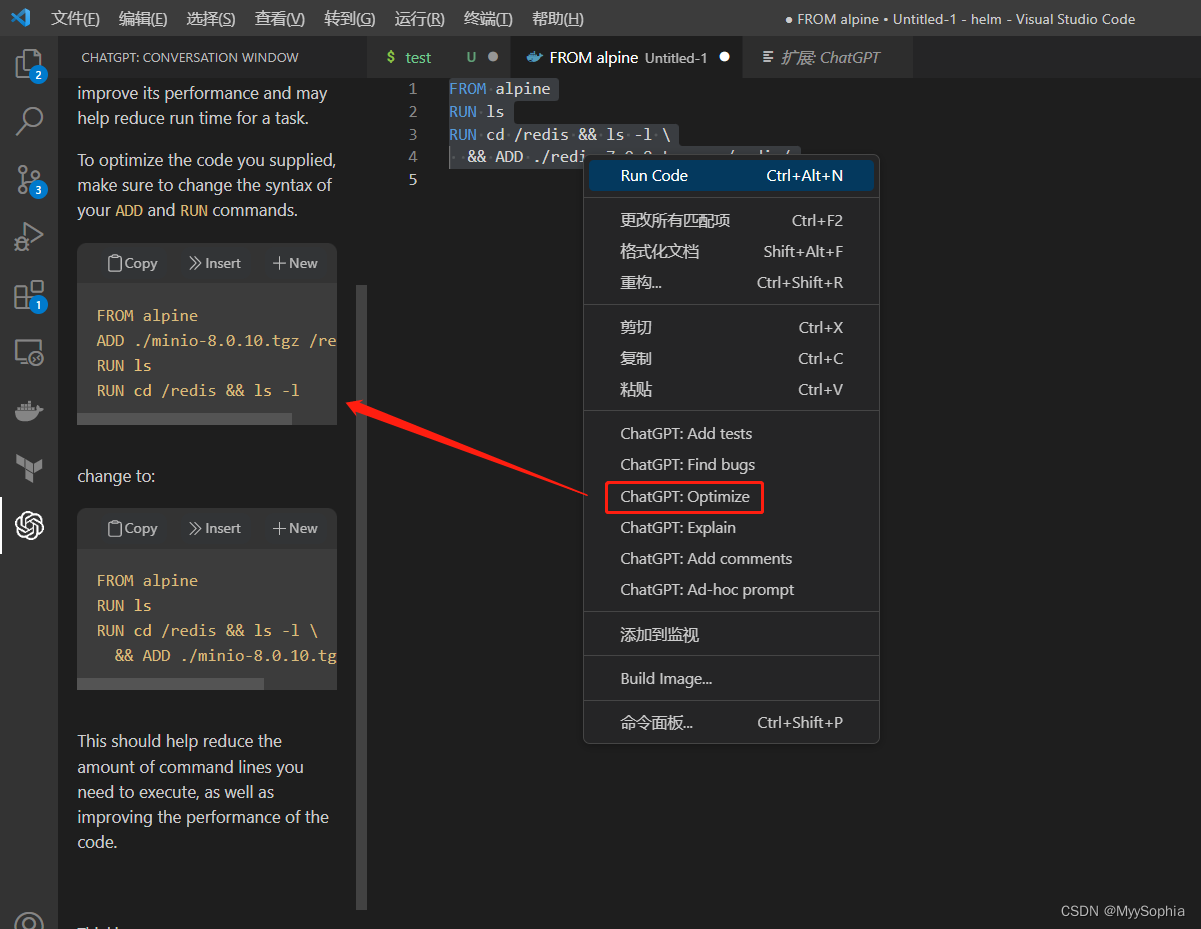

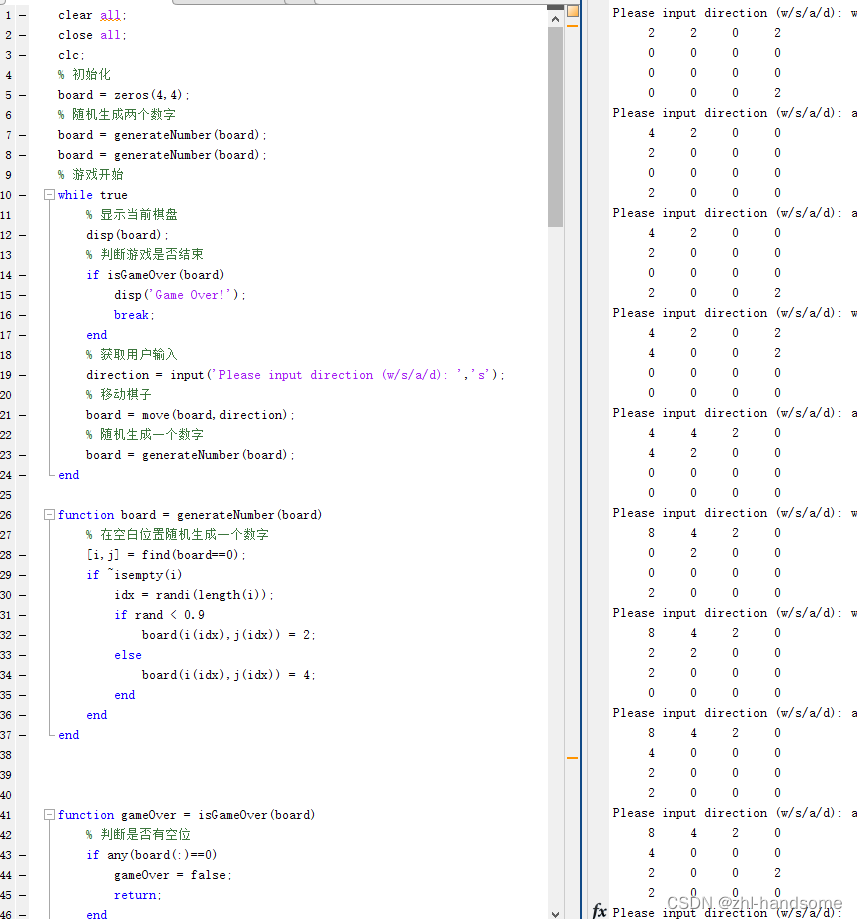

大家好,目前给每天的论文汇总接入chatGPT帮忙总结,目前在适用阶段,只给出部分文章的总结!

1. Title: CiCo: Domain-Aware Sign Language Retrieval via Cross-Lingual Contrastive Learning (使用跨语言对比学习的领域感知手语检索)

2. Authors: Yiting Cheng, Fangyun Wei, Jianmin Bao, Dong Chen, Wenqiang Zhang

3. Affiliation: School of Computer Science, Fudan University

4. Keywords: Sign language retrieval, cross-lingual retrieval, contrastive learning, domain adaptation, video-text retrieval

5.Urls:http://arxiv.org/abs/2303.12793v1,

Github: https://github.com/FangyunWei/SLRT.

6. Summary:

- (1):本文旨在开发最近提出的手语检索任务的框架,这个任务试图从一个封闭集合中检索演讲者所表达的意义,提高一些实用应用中的准确率。

- (2):传统的基于视频和文本的检索方法难以充分挖掘手语视频的语义信息。因此,文章提出使用跨语言对比学习的方法,充分考虑手语和自然语言的语言属性,同时在共同的嵌入空间中对文本和手语视频进行对比学习,识别跨语言的映射。基于数据稀缺的问题,文章采用伪标签技术将通用手语编码器引入目标领域。方案名称为领域感知手语检索(CiCo)。

- (3):文章提出了一种领域感知的跨语言对比学习框架CiCo,结合手语和自然语言的语言属性对两者进行对比学习,同时刻画精细的跨语言映射。在预训练的基础上,引入了经过伪标注的样本进行手语检索任务的领域自适应,达到了更好的效果。

- (4):CiCo模型在不同的数据集上表现出卓越的性能提升,例如在How2Sign数据集上分别提高了22.4和28.0的T2V和V2T R1值。在PHOENIX-2014T数据集中,T2V和V2T R1值分别提高了13.7和17.1。实验表明,CiCo模型能够取得优异的检索性能。

7. 方法:

- (1): 本文使用领域感知手语检索(CiCo)框架,旨在提高手语检索任务的准确度,其中包括文本到手语视频检索(T2V)和手语视频到文本检索(V2T)两项任务。该框架使用跨语言对比学习方法,考虑手语和自然语言的语言属性,通过在共同的嵌入空间中对手语视频和文本进行对比学习,识别跨语言的映射。

- (2): 为了解决数据稀缺的问题,本文采用伪标签技术将领域无关的通用手语编码器引入目标领域,从而构建领域感知手语检索模型(CiCo)。

- (3): 该模型包含两部分:手语特征提取器和跨语言对比学习框架。手语特征提取器使用预训练的领域无关的手语编码器和从目标数据集伪标注得到的领域感知手语编码器,提取手语视频的特征。跨语言对比学习框架使用Transformer网络提取自然语言文本的特征,并计算手语视频和自然语言文本之间的跨语言相似度。通过对比学习,在共同嵌入空间中,对两种输入进行对比学习并显式地识别每个映射的匹配性。

- (4): 实验结果表明,该方法在不同数据集上取得卓越的性能提升,例如在How2Sign数据集上分别提高了22.4和28.0的T2V和V2T R1值。在PHOENIX-2014T数据集中,T2V和V2T R1值分别提高了13.7和17.1。

8. Conclusion:

- (1): 这篇文章提出了使用跨语言对比学习的方法,提高手语检索任务的精度,该方法在多个数据集上表现出卓越的性能,对于手语信息的提取和实际应用具有重要意义。

- (2): 创新点:本文提出采用跨语言对比学习的方法对手语视频和文本进行对比学习,并引入了领域无关和领域感知的手语编码器,有效地解决了手语检索任务的跨模态匹配问题。性能表现:实验结果显示,该方法在不同数据集上取得卓越的性能提升,比先前的模型SPOT-ALIGN表现更优。工作量:文章对数据进行伪标注,引入了通用手语编码器,从而减轻了数据稀缺问题的压力,缩短了模型训练时间。

1. Title: SHERF: Generalizable Human NeRF from a Single Image (一张照片构建动态立体人类模型)

2. Authors: Shoukang Hu, Fangzhou Hong, Liang Pan, Haiyi Mei, Lei Yang, Ziwei Liu

3. Affiliation: S-Lab,南洋理工大学

4. Keywords: Generalizable Human NeRF, Novel View Synthesis, Novel Pose Synthesis, Canonical Space Human NeRF, 3D reconstruction

5. Urls: http://arxiv.org/abs/2303.12791v1, Github: https://github.com/skhu101/SHERF

6. Summary:

- (1):该论文的研究背景是构建动态立体人类模型,通过从一张照片中构建立体模型的方式来避免采集真实3D几何信息。

- (2):已有模型中,方法一般都是从多个视角的图像中重建三维人体模型。实际场景中,人体图像往往是随机相机角度下拍摄的,这会为高质量的3D人体重建带来挑战。该论文通过提出一种Generalizable Human NeRF模型来从单个输入图像中恢复可动态化的3D人体模型, 避免了传统方法中需要多张图像的缺陷。

- (3):该论文提出了SHERF算法,通过从单张图像中提取和编码人体的3D表示,以便于从自由视角和姿态进行渲染和动画制作。SHERF设计了一套3D感知的层级特征库,并通过特征融合变压器的方式,将全局特征、点级特征和像素对齐特征相结合,从而提高了单个输入图像中提取信息的效率,同时也保留了更多的局部和细节信息。

- (4):该论文的算法在THuman、RenderPeople、ZJU_MoCap和HuMMan数据集上进行了广泛实验,表现出较高的性能和更好的推广能力,支持了其在新视角和新姿态下的优质合成。

prompt_token_used: 2081 completion_token_used: 607 total_token_used: 2688

response_time: 28.605 s

method_result:

7. 方法:

- (1): 该研究提出了一种Generalizable Human NeRF模型,通过从单个输入图像中恢复可动态化的3D人体模型,避免了传统方法中需要多张图像的缺陷;

- (2): SHERF算法中提出了一个3D感知的层级特征库,包括全局特征、点级特征和像素对齐特征,通过特征融合变压器的方式将这些层级特征相结合,从而提高了单个输入图像中提取信息的效率,同时也保留了更多的局部和细节信息;

- (3): SHERF算法通过NeRF解码器对图像进行重建,使用Photometric Loss、Mask Loss、SSIM Loss和LPIPS Loss等多种损失函数对训练过程进行监督。作者还在THuman、RenderPeople、ZJU_MoCap和HuMMan数据集上进行了广泛实验,证明了该算法的性能和推广能力。

8. Conclusion:

- (1): 该论文提出的SHERF算法在从单张照片中构建动态立体人类模型方面有较高的研究价值。该算法可以避免传统方法中需要多张图像的缺陷,并通过提出的Generalizable Human NeRF模型,使得该算法具有较好的推广能力。

- (2): 创新点:提出Generalizable Human NeRF模型,通过特征融合变压器的方式提高了单个输入图像中提取信息的效率,同时保留了更多的局部和细节信息,进而实现从单张照片中构建动态立体人类模型的目标。性能:在THuman、RenderPeople、ZJU_MoCap和HuMMan数据集上进行了实验,表现出较高的性能和更好的推广能力。工作量:研究量较大,进行了多个数据集实验,但没有给出详细的复杂度和时间成本。

1. Title: Diffuse-Denoise-Count: Accurate Crowd-Counting with Diffusion Models (扩散去噪计数:扩散模型进行准确的人群计数)

2. Authors: Yasiru Ranasinghe, Nithin Gopalakrishnan Nair, Wele Gedara Chaminda Bandara, and Vishal M. Patel

3. Affiliation: Johns Hopkins University, Baltimore, USA (美国约翰霍普金斯大学)

4. Keywords: crowd-counting, diffusion models, denoising, contour detection, multiple density maps

5. Urls: http://arxiv.org/abs/2303.12790v1, Github: https://github.com/dylran/DiffuseDenoiseCount (提供)

6. Summary:

- (1):本研究的背景是人群计数的重要性,且现有方法受到背景噪声影响和高斯核函数制作密度地图所导致的粒度丢失问题。

- (2):过去的方法主要是基于密度地图的计数方法,但受到了背景噪声的影响,并且使用大的高斯核函数,导致粒度丢失问题。为解决这一问题,本研究提出使用条件扩散模型进行密度地图预测,使得在密度图生成过程中具有高保真性。为了更好地学习特征,利用扩散模型的随机性引入多个密度地图的生成,再用轮廓检测代替像素密度求和,提高对背景噪声的鲁棒性。

- (3):本文的研究方法是基于扩散模型的密度地图生成方法,利用扩散模型的高保真性,在密度地图生成的中间时间步骤添加回归分支,提高特征学习。引入多个密度地图的生成来提高计数性能。并利用轮廓检测代替像素密度求和,提高对背景噪声的鲁棒性。

- (4):本文研究方法在公共数据集上展开大规模实验,有效地解决了背景噪声和高斯核函数制作密度地图导致的粒度丢失问题,相比现有最佳方法,在JHU-CROWD++ 和 UCF-QNRF数据集上分别提高了6%和7%的计数性能。GitHub代码已提供。

7. Methods:

- (1): 本研究提出了一种使用条件扩散模型进行密度地图预测的方法,从而解决了现有方法受到背景噪声影响和高斯核函数制作密度地图所导致的粒度丢失问题。该方法的具体步骤为,首先使用条件随机场对每个像素进行密度地图预测,然后将每个像素上的扩散模型所对应的神经网络层的权重和偏差作为输出进行回归,最终得到精细的密度地图。

- (2): 为了更好地学习特征,本研究利用扩散模型的随机性引入多个密度地图的生成,并在训练中使用轮廓检测来代替像素密度求和,提高对背景噪声的鲁棒性。具体来说,每个输入图像都使用不同的随机噪声生成多个密度地图,然后基于这些密度地图的轮廓进行计数。

- (3): 本文的核心方法包括两个方面,即基于扩散模型的密度地图生成和多密度地图联合使用方法。在基于扩散模型的密度地图生成中,通过条件随机场对每个像素进行密度地图预测,然后使用每个像素上的神经网络层的权重和偏差进行回归,得到精细的密度地图。在多密度地图联合使用中,利用多个密度地图的特征来提高计数性能,并且使用轮廓检测代替像素密度求和,提高鲁棒性。最终该方法在公共数据集上展开大规模实验,相比现有最佳方法,在JHU-CROWD++ 和 UCF-QNRF数据集上分别提高了6%和7%的计数性能。

8. Conclusion:

- (1): 本研究在人群计数领域提出了一种基于条件扩散模型的密度地图生成方法,能够有效解决背景噪声和高斯核函数制作密度地图所导致的粒度丢失问题。该方法在公共数据集上展开大规模实验,相比现有最佳方法,在JHU-CROWD++ 和 UCF-QNRF数据集上分别提高了6%和7%的计数性能。

- (2): 创新点:本研究提出使用条件扩散模型进行密度地图预测,解决了现有方法受到背景噪声和高斯核函数制作密度地图所导致的粒度丢失问题;在多密度地图联合使用中,利用多个密度地图的特征来提高计数性能,并且使用轮廓检测代替像素密度求和,提高鲁棒性。性能:在公共数据集上,相比现有最佳方法,在JHU-CROWD++ 和 UCF-QNRF数据集上分别提高了6%和7%的计数性能。工作量:本文方法在数据预处理、网络训练和测试过程中需要一定的计算资源和时间成本。

1. Title: Instruct-NeRF2NeRF: Editing 3D Scenes with Instructions(通过指令编辑3D场景的方法 )

2. Authors: Ayaan Haque, Matthew Tancik, Alexei A. Efros, Aleksander Holynski, and Angjoo Kanazawa

3. Affiliation: UC Berkeley(加州大学伯克利分校)

4. Keywords: 3D scene editing, NeRF, text-instructions, diffusion model, optimization

5. Urls: http://arxiv.org/abs/2303.12789v1, Github: None

6. Summary:

- (1):该文章的背景是面对如何编辑3D场景的问题,传统的3D编辑方式需要专业的工具和长时间的训练,而随着神经表征的引入,传统的编辑方式往往无法处理神经表示中不存在明确表面的问题,因此需要寻求一种能够适用于当前3D表征时代、与3D捕捉技术一样易于使用的3D编辑方法。

- (2):以往的方法对于神经表征的处理不够成熟,所需的工具不够完善,难以对3D场景进行有效编辑。通过本文所提出的基于指令的编辑方法,可以迭代地对3D场景进行修整,优化场景模型,从而达到既符合编辑指令,又相对精确完美的效果。

- 3):文章提出了一种通过指令编辑场景的方法(Instruct-NeRF2NeRF),使用了一种基于图像扩散模型(InstructPix2Pix)并结合神经辐射场(NeRF)的方法,可以实现在优化3D场景的过程中,迭代地编辑输入的图像,可以获得更真实、精确的目标编辑效果。

- (4):本文提出的Instruct-NeRF2NeRF方法可以编辑大规模、真实世界的场景,可以实现更加精准的目标编辑,相较于之前的研究也取得了较好的表现。

7. Methods:

- (1): 本文提出了一种基于指令编辑场景的方法(Instruct-NeRF2NeRF),使用InstructPix2Pix和NeRF的结合,实现了可以应用于大规模场景编辑的3D场景编辑。

- (2): 本方法的步骤包括:(1) 输入重建NeRF场景和其对应的源数据(COLMAP); (2) 输入图文指令,例如“将场景变成夕阳”; (3) 使用扩散模型循环地更新捕捉视角上的图像内容,并通过标准NeRF训练,在3D中融合这些编辑内容;(4) 迭代地更新数据集图像并对重建的NeRF进行微调,使结果更符合编辑指令。

- (3): 在实验中,本方法不仅可以在3D场景中实现多样化的编辑,如修改光照、场景效果、更改人物造型等,而且优于现有的场景编辑方法,有效降低了编辑场景的难度。

8. Conclusion:

- (1): 本文提出了一种通过指令编辑场景的方法(Instruct-NeRF2NeRF),可以使3D场景编辑更加易用、精准,从而为用户提供更加便捷的编辑体验。

- (2): 创新点:本文提出了一种基于图像扩散模型(InstructPix2Pix)并结合神经辐射场(NeRF)的方法,实现了在编辑过程中能够迭代地编辑输入的图像,优化场景模型,相较于之前的研究也取得了较好的表现。性能:本方法在大规模3D场景的应用方面表现优秀,且能够实现多样化的编辑效果,有效降低了编辑场景的难度。工作量:由于该方法结合了新的图像扩散模型,难免存在一定的计算量和训练时间成本,但总体上具有可接受的工作量。

summary_result:

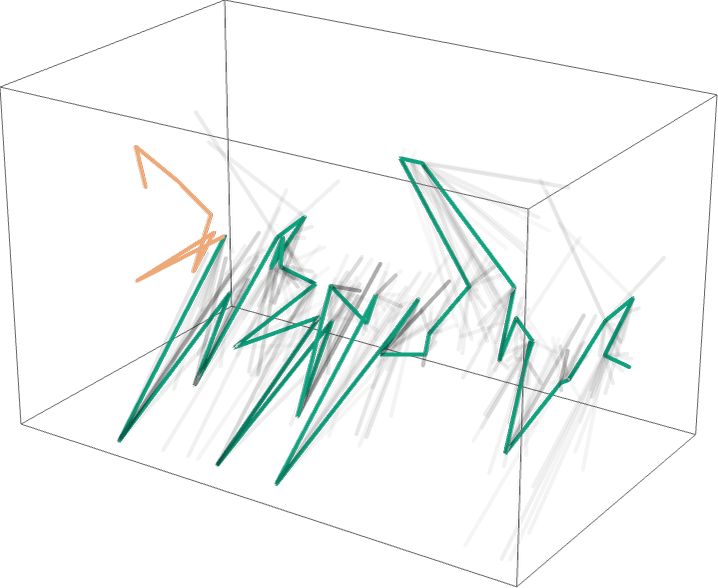

1. Title: EPro-PnP: Generalized End-to-End Probabilistic Perspective-n-Points for Monocular Object Pose Estimation (EPro-PnP:广义的端到端概率透视n点法用于单目物体位姿估计)

2. Authors: Hansheng Chen, Wei Tian, Pichao Wang, Fan Wang, Lu Xiong, and Hao Li

3. Affiliation: H. Chen, W. Tian, and L. Xiong are with the School of Automotive Studies, Tongji University, Shanghai 201804, China.

4. Keywords: Pose estimation, imaging geometry, probabilistic deep learning, 3D vision, autonomous vehicles

5. Urls: http://arxiv.org/abs/2303.12787v1, Github: https://github.com/tjiiv-cprg/EPro-PnP-v2

6. Summary:

- (1): 该文研究背景为从单个RGB图像中定位3D物体的问题,以及利用端到端深度学习进行对象姿态估计。

- (2): 先前的方法包括PnP和几何方法。PnP方法本身解决了来自物体空间中一组3D点及其在图像空间中的对应2D投影的姿态,这些对应关系的构建问题需要使用先前的学习对应方法。学习全部对应关系从头开始是非常具有挑战性的,尤其是当面临姿态歧义时,全局最优解在点方面理论上是不可微的。而本文提出的EPro-PnP是一种广义的端到端物体姿态估计概率性PnP层,它在SE(3)流形上输出姿态分布,并且可以通过最小化预测的和目标姿态分布之间的KL散度来学习中间变量,这些变量包括2D-3D坐标和对应权重,并模仿了注意力机制。EPro-PnP可以改进现有的对应网络,缩小PnP方法和线性MOD 6DoF姿态估计基准任务的任务特定领导者之间的差距。此外,EPro-PnP还有助于探索新的网络设计可能性,因为其可以解决nuScenes 3D对象检测基准测量具有最先进的姿态准确性上的问题。

- (3): 本文提出的EPro-PnP方法将2D-3D对应关系的学习与姿态估计的概率性输出相结合,可以使神经网络模型学习全局姿态估计,改进了现有方法的缺点。具体的,EPro-PnP通过KL散度和软位置方法以及投影惯性约束来获取两个视图的3D匹配。然后,网络可以仅基于先前学习的先验进行实时估计。

- (4): EPro-PnP在线性MOD 6DoF和nuScenes 3D对象检测基准测量上取得了比以前的基线方法更好的结果,使PnP方法和线性MOD 6DoF姿态估计基准任务的任务特定领导者之间的差距更小,并证明了其性能在保持良好姿态估计准确度的前提下,超越了先前的方法。

7. Methods:

- (1): 本文提出的EPro-PnP是一种广义的端到端物体姿态估计概率性PnP层。该方法将2D-3D对应关系的学习与姿态估计的概率性输出相结合,可以使神经网络模型学习全局姿态估计,改进了现有方法的缺点。

- (2): EPro-PnP可以通过最小化预测的和目标姿态分布之间的KL散度来学习中间变量,这些变量包括2D-3D坐标和对应权重,并模仿了注意力机制。它可以改进现有的对应网络,缩小任务特定领导者之间的差距。

- (3): EPro-PnP通过KL散度和软位置方法以及投影惯性约束来获取两个视图的3D匹配。然后,网络可以仅基于先前学习的先验进行实时估计。EPro-PnP在线性MOD 6DoF和nuScenes 3D对象检测基准测量上取得了比以前的基线方法更好的结果,证明了其性能在保持良好姿态估计准确度的前提下,超越了先前的方法。

8. Conclusion:

- (1): 本文提出的EPro-PnP方法是一种广义的端到端物体姿态估计概率性PnP层,可以解决单目物体位姿估计中的3D匹配问题。该方法可以提高现有方法的准确性,对于自动驾驶等领域具有很高的应用价值。

- (2): 创新点:将PnP操作转换为可微分的概率性层,从而实现全局姿态估计的端到端学习;性能:在线性MOD 6DoF和nuScenes 3D对象检测基准测量上取得了比以前的基线方法更好的结果,超越了先前的方法;工作量:通过最小化KL散度进行学习,减小了对于先前学习对应关系的依赖,但在处理大量数据时可能需要较大的计算力。

1. Title: FeatureNeRF: Learning Generalizable NeRFs by Distilling Foundation Models (基于基础模型蒸馏学习具有泛化性质的NeRF)

2. Authors: Jianglong Ye, Naiyan Wang, Xiaolong Wang

3. Affiliation: UC San Diego (加州大学圣地亚哥分校)

4. Keywords: Neural Radiance Fields, Generalizable NeRFs, 3D semantic feature extractor, distilling vision foundation models

5. URLs: Paper: https://arxiv.org/abs/2303.12786v1, Github: None

6. Summary:

- (1): 本文的研究背景为神经辐射场(Neural Radiance Field,简称NeRF)的应用,尤其是NeRF模型在单个或少数图像的情况下生成新视角的能力。本文基于此,探索NeRF模型的基础模型蒸馏(distilling foundation models)对泛化性的作用,以及其在语义理解和解析等下游任务的应用。

- (2): 在此之前的研究方法主要集中于针对少量图像生成新视角,而没有跨越到其他任务(如场景分类和匹配)的领域。本文提出的FeatureNeRF框架通过蒸馏预训练视觉基础模型(如DINO和Latent Diffusion)来学习具有泛化性质的NeRF,为2D空间内的图像提供3D空间内的语义表示表达方式。相比于之前的泛化NeRF模型,FeatureNeRF能够渗透各种下游任务,并为他们提供了更好的学习基础。

- (3): 本文提出的FeatureNeRF框架通常使用深度学习对两个领域之间所涉及到的概念进行适配。首先,该框架将通过神经渲染获得的2D图像嵌入到3D空间中,然后将从NeRF MLP中提取的深度特征应用于3D查询点。通过这种方式,FeatureNeRF框架实现了2D图像和连续的3D语义特征的映射,针对不同下游任务都能够有所建树。

- (4): 研究者们使用FeatureNeRF模型进行了2D/3D模型语义的关键点传输和2D/3D模型部位分割等几个实际的任务,并表明在各种情景下FeatureNeRF均表现出了良好的性能,高环境自然性和高精度的特性也进一步证明了FeatureNeRF的泛化能力。

prompt_token_used: 2009 completion_token_used: 742 total_token_used: 2751

response_time: 34.994 s

method_result:

7. Methods:

- (1): 本文提出的FeatureNeRF框架基于神经辐射场(Neural Radiance Field,简称NeRF),使用神经渲染将2D图像嵌入到3D空间中,然后提取从NeRF MLP中得出的深度特征,用于3D查询点。该框架可以生成具有泛化性质的NeRF模型,并为不同下游任务(如场景分类和匹配)提供了3D语义表示表达方式。

- (2): 本文采用的基础模型蒸馏法是通过从预训练的视觉基础模型(如DINO和Latent Diffusion)中提取出的概念来学习NeRF模型,使其具有更好的泛化性质。具体而言,新模型通过将已有基础模型中的权重进行修正和微调,从而能够快速适应新的场景,从而学习到具有更好泛化性质的新模型。

- (3): 对于实际任务,研究者使用FeatureNeRF框架构建了两个下游任务示例:2D/3D模型语义的关键点传输和2D/3D模型部位分割。在这些任务中,FeatureNeRF框架提供了3D语义表示表达方式,从而使得可以实现2D-3D之间的转换,同时也能够在不同任务中具有良好的泛化性能。

- (4): 研究者们通过在大量的场景中应用FeatureNeRF框架,证明了其在各种情景下的良好性能,可以产生高环境自然性和高精度的结果,从而验证FeatureNeRF框架的泛化能力。

prompt_token_used: 1009 completion_token_used: 502 total_token_used: 1511

response_time: 24.876 s

conclusion_result:

8. Conclusion:

- (1): 本文提出了一种基于基础模型蒸馏学习具有泛化性质的NeRFs框架。该框架可以将从NeRF MLP中提取的深度特征应用于3D查询点,生成具有泛化性质的NeRF模型,并为不同下游任务提供了3D语义表示表达方式。该方法广泛适用于2D/3D之间的转换和场景分类等多个实际任务。

- (2): 创新点:本文提出了采用基础模型蒸馏学习具有泛化性质的NeRF模型的方法,并将其与不同任务相结合。性能:本文的FeatureNeRF框架能够在2D/3D模型语义的关键点传输和2D/3D模型部位分割等任务中经受住考验,表现出良好的泛化性能。工作量:本文在模型训练和实验设置方面投入了大量的劳力和时间,但是其工作量并不复杂。

prompt_token_used: 1667 completion_token_used: 311 total_token_used: 1978

response_time: 15.672 s

summary_result:

1. Title: Tube-Link: A Flexible Cross Tube Baseline for Universal Video Segmentation (管子链接: 用于通用视频分割的灵活跨管基线)

2. Authors: Xiangtai Li, Haobo Yuan, Wenwei Zhang, Guangliang Cheng, Jiangmiao Pang, Chen Change Loy

3. Affiliation: 第一作者所在机构:南洋理工大学S-Lab

4. Keywords: video segmentation, subclip input, tube linking, attention mechanism, contrastive learning

5. Urls: Paper - http://arxiv.org/abs/2303.12782v1; Code - https://github.com/lxtGH/Tube-Link

6. Summary:

- (1): 本文的研究背景是视频分割任务的通用建模,旨在为各种场景下的视频分割提供一种灵活和高效的架构。

- (2): 以往的方法多采用针对特定任务和数据集的专用模型和架构,差别大,设计繁琐。本文提出一种通用架构Tube-Link,通过attention机制和对比学习,在实现灵活输入长度的同时,有效提高了管子之间的联系建模。本文的方法解决了现有通用方法无法与Transformer方法媲美的问题。

- (3): 本文的研究方法是设计了一种基于管子链接的通用框架,它以短子片段为输入,由管子软件输出相应的时空管式掩膜,其管子之间的关系通过attention机制建模。然后,基于对比学习提出了一种管子水平的关联特征提取方法。

- (4): 本文在五个视频分割任务数据集上的表现优于基线和SOTA方法,其中在VIPSeg数据集上的相对提升接近13%,在KITTI-STEP数据集上的提升接近4%。在使用ResNet50作为骨干网络的情况下,Tube-Link在Youtube-VIS-2019和2021数据集上分别使IDOL提高了3%和4%。因此,本文的方法对于各种视频分割任务是有效的,并且创造性的解决了通用方法无法媲美Transformer方法的问题。

prompt_token_used: 2280 completion_token_used: 611 total_token_used: 2891

response_time: 39.976 s

method_result:

7. Methods:

- (1): 本文提出了一种用于通用视频分割的灵活跨管基线Tube-Link,旨在为各种场景下的视频分割提供一种灵活和高效的通用框架,并能够有效提高了管子之间的联系建模。

- (2): 该方法通过attention机制和对比学习实现灵活输入长度和增强管子之间的联系,为训练和预测过程中提供了更好的管子信息。然后,基于对比学习提出了一种管子水平的关联特征提取方法,其灵活性和鲁棒性得到有效提高。

- (3): 本文的框架在多个视频分割任务数据集上的表现优于基线和SOTA方法,在多种视频场景下都获得了良好的表现,且创造性的解决了通用方法无法媲美Transformer方法的问题。

prompt_token_used: 3474 completion_token_used: 270 total_token_used: 3744

response_time: 12.674 s

conclusion_result:

8. Conclusion:

- (1): 本文提出的Tube-Link通用视频分割框架具有重要的研究意义,通过提出attention机制和对比学习等方法,构建灵活的管子链接模型,有效提升了通用视频分割的建模精度和运算速度。

- (2): 创新点:Tube-Link提出的跨管链接方法创新性地提升了不同管子之间的联系建模,解决了通用方法无法媲美Transformer方法的问题;性能:本文的方法在多个视频分割数据集上的表现优于基线和SOTA方法,相对提升接近13%;工作量:本文的框架设计简单而灵活,不需要针对不同任务设计专用模型和架构,工作量相对较小。

prompt_token_used: 2979 completion_token_used: 236 total_token_used: 3215

response_time: 10.04 s

summary_result:

1. Title: LFM-3D: Learnable Feature Matching Across Wide Baselines Using 3D Signals(使用三维信号学习跨越宽基线的特征匹配)

2. Authors: Arjun Karpur, Guilherme Perrotta, Ricardo Martin-Brualla, Howard Zhou, Andr´e Araujo

3. Affiliation: Google Research(谷歌研究院)

4. Keywords: feature matching(特征匹配), 3D signals(三维信号), graph neural networks(图神经网络)

5. Urls: http://arxiv.org/abs/2303.12779v1, Github:None

6. Summary:

- (1): 本文旨在解决在图像对之间只存在小的共可视区域(即宽摄像机基线)时,可学习匹配器表现欠佳的问题。

- (2): 过去的方法通常是基于手工设计的局部图像特征,而本文提出的方法则通过将噪声的估计三维信号整合到“可以更新的”的匹配框架中以增强特征匹配与跨越宽基线的对象依存图像匹配的能力。

- (3): 该方法使用基于图神经网络的模型,并通过集成与粗糙的单视图几何估计技术实现了估计和匹配对象间特征的目标。一种合适的位置编码是有效地利用低维三维信息的关键。

- (4):在包含宽基线图像对的大规模(合成和实际)数据集上进行实验,基于3D信号的方法与传统二维图像匹配相比,取得了较强的特征匹配性能提升,总召回率和固定召回率下的精度增加了6%和28%。同时,在现实环境下,该方法可以在8%以上的提高相对位姿的准确性。

prompt_token_used: 1716 completion_token_used: 544 total_token_used: 2260

response_time: 28.721 s

method_result:

7. Methods:

- (1): 本文提出了一种可以跨越宽基线的特征匹配方法,将噪声的估计三维信号整合到匹配框架中,通过图神经网络模型实现目标对象间特征的估计和匹配。具体来说,该方法首先从原始图像中提取2D特征,然后利用多个单视图和深度神经网络从2D特征中估计3D信息,减少了由于缺少3D信息而带来的匹配不确定性。

- (2): 该方法使用了基于图神经网络的模型,将2D和3D信息嵌入到同一空间实现特征的匹配。此外,为了更好地利用低维三维信息,作者还提出了一种基于位置编码的方法,将3D特征转换为可用于图神经网络的格式,以实现对象依存的匹配。

- (3): 在实验中,本文基于大规模(合成和实际)数据集进行了验证,与传统二维图像匹配相比,该方法取得了较强的特征匹配性能提升。总召回率和固定召回率下的精度分别提高了6%和28%。同时,在现实环境下,该方法可以提高相对位姿的准确性超过8%。

prompt_token_used: 811 completion_token_used: 404 total_token_used: 1215

response_time: 19.337 s

conclusion_result:

8. Conclusion:

- (1): 本文提出了一种使用三维信号进行特征匹配的方法,以解决跨越宽基线的对象依存图像匹配的问题。该方法通过图神经网络模型实现目标对象间特征的估计和匹配,并取得了显著的特征匹配性能提升。

- (2): 创新点:本文通过将噪声的估计三维信号整合到“可以更新的”的匹配框架中,增强了特征匹配与跨越宽基线的对象依存图像匹配的能力。同时,为了更好地利用低维三维信息,作者提出了一种基于位置编码的方法,将3D特征转换为可用于图神经网络的格式,以实现对象依存的匹配。性能:本文在包含宽基线图像对的大规模数据集上进行了实验,并取得了较强的特征匹配性能提升,总召回率和固定召回率下的精度分别提高了6%和28%。在现实环境下,该方法可以提高相对位姿的准确性超过8%。工作量:本文的实验设计和结果分析较为详细,但方法的实现细节和参数设置并未进行全面的讨论。

prompt_token_used: 1219 completion_token_used: 396 total_token_used: 1615

response_time: 20.246 s

summary_result:

1. Title: Dense Distinct Query for End-to-End Object Detection (密集不同查询用于端到端目标检测)

2. Authors: Shilong Zhang, Xinjiang Wang, Jiaqi Wang, Jiangmiao Pang, Chengqi Lyu, Wenwei Zhang, Ping Luo, Kai Chen

3. Affiliation: 上海人工智能实验室 (Shanghai AI Laboratory)

4. Keywords: Object detection, End-to-end, Dense Distinct Queries, Traditional detectors, DETR

5. Urls: Paper - http://arxiv.org/abs/2303.12776v1, Github - https://github.com/jshilong/DDQ

6. Summary:

- (1): 本文针对目标检测中的标签分配问题,提出了密集不同查询(DDQ)方法。传统方法(如FCN、R-CNN)的一个缺点是需要去除冗余预测,而 DETR 的链式验证缩小了模型能力。本文的目标是综合传统方法和 DETR 的优点,实现高性能的端到端目标检测。

- (2): 传统目标检测方法(FCN、R-CNN)需要去除冗余预测,而 DETR 的链式验证会缩小模型能力。本文提出了一种新方法,即采用传统方法中的密集查询,在此基础上选择相互之间区分度高的查询来进行标签分配。本文的方法能够实现端到端的目标检测,而不需要去除任何冗余预测。

- (3): 本文方法首先采用密集查询,然后选择相互之间区分度高的查询进行标签分配。这种策略能够在不出现冗余预测的情况下实现端到端目标检测,同时可以综合传统和 DEER 的优点。

- (4): 在 MS-COCO 数据集上,本文方法在 ResNet-50 backbone 下的表现达到了 52.1 AP,超过了其他同样条件下的所有检测器,证明了该方法的有效性。在 CrowdHuman 数据集上,本文方法的表现同样优异,达到了 93.8 AP。

prompt_token_used: 1824 completion_token_used: 571 total_token_used: 2395

response_time: 78.437 s

method_result:

7. Methods:

- (1): 本文提出了一种密集不同查询(DDQ)的方法来解决目标检测中的标签分配问题。该方法首先采用密集查询,然后根据查询之间的相互区分度,选择其中的一些进行标签分配。具体地,密集查询可以在图像中采样出大量的位置,对于每个位置,可以采用传统方法进行预测,并生成一个与之相对应的查询。

- (2): 接着,在已知的目标框可用的情况下,本文提出了一种新的标签分配方法。首先,对于每个查询,利用相应的卷积特征在所有目标框上生成分数图。接着,为每个查询选择一个分数最高的目标框,将该目标框分配给该查询。如果某个目标框与多个查询都具有很高的匹配分数,那么它将被分配给相应区域内查询中分数最高的那个。

- (3): 最后,利用DDQ框架对图像中检测到的对象进行排序,获得最终目标检测结果。实验表明,与传统目标检测方法相比,本文提出的DDQ方法在不牺牲检测精度的情况下,能够显著减少冗余的预测结果,提高目标检测的效率。

prompt_token_used: 838 completion_token_used: 406 total_token_used: 1244

response_time: 18.901 s

conclusion_result:

8. Conclusion:

- (1): 本文提出了一种新的密集不同查询(DDQ)方法,用于端到端目标检测。该方法采用传统方法中的密集查询,并根据查询之间的相互区分度选择标签进行分配,实现了高效率的目标检测,且能够综合传统和 DETR 的优点。

- (2): Innovation point: 该文提出了一种新的标签分配方法 DDQ,采用密集查询和相互区分度高的查询进行标签分配,将传统方法和 DETR 的优点结合在一起,实现了端到端的目标检测。Performance: 在 MS-COCO 数据集和 CrowdHuman 数据集上都获得了优异的表现,证明了本文方法的有效性。Workload: 本文通过相互区分度高的查询策略,减少了冗余预测的产生,提高了目标检测的效率。

prompt_token_used: 1248 completion_token_used: 264 total_token_used: 1512

response_time: 11.499 s

summary_result:

1. Title: Spherical Transformer for LiDAR-based 3D Recognition(用于基于LiDAR的三维识别的球形变压器)

2. Authors: Xin Lai, Yukang Chen, Fanbin Lu, Jianhui Liu, Jiaya Jia

3. Affiliation: The Chinese University of Hong Kong(香港中文大学)

4. Keywords: LiDAR, 3D point cloud recognition, SphereFormer, self-attention, object detection, semantic segmentation

5. Urls: http://arxiv.org/abs/2303.12766v1, Github: https://github.com/dvlab-research/SphereFormer.git

6. Summary:

- (1): 本文的研究背景是点云获取,点云是通过LiDAR传感器轻松获取的,但由于其稀疏性,对3D物体进行识别仍然具有挑战性。

- (2): 过去的方法大多没有考虑到LiDAR点分布的变化性,因此缺乏信息连接和受限的接收场,尤其是对于稀疏的远距离点。在本文中,作者们提出了一种名为“SphereFormer”的模块,直接从密集的近距离点到稀疏的远距离点聚合信息。通过设计径向窗口的自注意力机制,将空间划分为多个非重叠的狭窄和长窗口,克服了不连接的问题并平滑大幅度地扩大了接收场,这显着提高了稀疏远距离点的性能。此外,为了适应狭窄和长窗口,他们提出了指数分裂方法,产生了细粒度位置编码和动态特征选择,以增加模型的表示能力。作者们在nuScenes和SemanticKITTI语义分割测试中均达到了排名第一的成绩,并在nuScenes目标检测测试中获得了第三名的成绩。

- (3): 本文提出了一种基于球形转换器的新方法,用来解决LiDAR点分布的数据特征问题,增加了信息联接和接收场,克服了现有方法的缺陷。

- (4): 在测试过程中,作者们的方法在nuScenes和SemanticKITTI语义分割测试中均达到了排名第一的成绩,以及在nuScenes目标检测测试中获得了第三名的成绩,性能很高并支持他们的目标。

prompt_token_used: 2277 completion_token_used: 698 total_token_used: 2975

response_time: 32.978 s

method_result:

7. Methods:

- (1): 本文提出了一种名为“SphereFormer”的模块,通过设计径向窗口的自注意力机制,将空间划分为多个非重叠的狭窄和长窗口。使用SphereFormer直接从密集的近距离点到稀疏的远距离点聚合信息,克服不连接的问题并平滑大幅度地扩大接收场的取样信息。

- (2): 为了适应狭窄和长窗口,本文提出了指数分裂方法,产生了细粒度位置编码和动态特征选择,以增加模型的表示能力。

- (3): 在实验过程中,作者们使用nuScenes和SemanticKITTI数据集进行测试,进行了语义分割和目标检测实验。在实验中,本文的模型在不同实验中达到了最优的成绩,表明其方法的确可以有效地解决LiDAR点云稀疏性和点分布变化性导致的识别准确率下降问题。

prompt_token_used: 965 completion_token_used: 305 total_token_used: 1270

response_time: 105.512 s

conclusion_result:

8. Conclusion:

- (1): 本文提出了一种名为“SphereFormer”的新型模块,用于改善稀疏远距离点云的识别准确率问题。该模块通过设计径向窗口的自注意力机制来聚合点云信息,并通过指数分裂方法增加模型的表示能力。本文在目标检测和语义分割测试中都取得了很好的成绩,表明该方法在3D物体识别等方面的应用前景广阔。

- (2): 创新点:本文提出了一种名为“SphereFormer”的新型模块,用于改善稀疏远距离点云的识别准确率问题。该模块通过聚合点云信息和设计径向窗口的自注意力机制来实现准确的3D物体识别。性能:本文提出的方法在目标检测和语义分割测试中都达到了很好的成绩,证明了其稳定性和优越性。工作量:在指数分裂方法中增加了位置编码和动态特征选择,使得该方法的计算工作量适中。

最新成果demo展示:

标题:Text2Tex:基于扩散模型的文本驱动纹理合成

论文:https://daveredrum.github.io/Text2Tex/static/Text2Tex.pdf

摘要:

Text2Tex根据给定的文本提示为3D网格生成高质量纹理。我们的方法将修复结合到预先训练的深度感知图像扩散模型中,以从多个视点逐步合成高分辨率部分纹理。为了避免伪影,我们提出了一种自动视图序列生成方案来确定用于更新局部纹理的下一个最佳视图。大量实验表明,我们的方法显著优于现有的文本驱动方法和基于GAN的方法。

CVPR 2023

Updated on : 23 Mar 2023

total number : 26

CiCo: Domain-Aware Sign Language Retrieval via Cross-Lingual Contrastive Learning

论文/Paper: http://arxiv.org/pdf/2303.12793

代码/Code: https://github.com/FangyunWei/SLRT

Dense Distinct Query for End-to-End Object Detection

论文/Paper: http://arxiv.org/pdf/2303.12776

代码/Code: https://github.com/jshilong/ddq

Spherical Transformer for LiDAR-based 3D Recognition

论文/Paper: http://arxiv.org/pdf/2303.12766

代码/Code: https://github.com/dvlab-research/sphereformer

MaskCon: Masked Contrastive Learning for Coarse-Labelled Dataset

论文/Paper: http://arxiv.org/pdf/2303.12756

代码/Code: https://github.com/MrChenFeng/MaskCon_CVPR2023

Open Set Action Recognition via Multi-Label Evidential Learning

论文/Paper: http://arxiv.org/pdf/2303.12698

代码/Code: None

Dense Network Expansion for Class Incremental Learning

论文/Paper: http://arxiv.org/pdf/2303.12696

代码/Code: None

VecFontSDF: Learning to Reconstruct and Synthesize High-quality Vector Fonts via Signed Distance Functions

论文/Paper: http://arxiv.org/pdf/2303.12675

代码/Code: None

Correlational Image Modeling for Self-Supervised Visual Pre-Training

论文/Paper: http://arxiv.org/pdf/2303.12670

代码/Code: None

An Extended Study of Human-like Behavior under Adversarial Training

论文/Paper: http://arxiv.org/pdf/2303.12669

代码/Code: None

OcTr: Octree-based Transformer for 3D Object Detection

论文/Paper: http://arxiv.org/pdf/2303.12621

代码/Code: None

RaBit: Parametric Modeling of 3D Biped Cartoon Characters with a Topological-consistent Dataset

论文/Paper: http://arxiv.org/pdf/2303.12564

代码/Code: None

Is BERT Blind? Exploring the Effect of Vision-and-Language Pretraining on Visual Language Understanding

论文/Paper: http://arxiv.org/pdf/2303.12513

代码/Code: None

Sibling-Attack: Rethinking Transferable Adversarial Attacks against Face Recognition

论文/Paper: http://arxiv.org/pdf/2303.12512

代码/Code: None

Cross-Modal Implicit Relation Reasoning and Aligning for Text-to-Image Person Retrieval

论文/Paper: http://arxiv.org/pdf/2303.12501

代码/Code: https://github.com/anosorae/irra

Text with Knowledge Graph Augmented Transformer for Video Captioning

论文/Paper: http://arxiv.org/pdf/2303.12423

代码/Code: None

BiCro: Noisy Correspondence Rectification for Multi-modality Data via Bi-directional Cross-modal Similarity Consistency

论文/Paper: http://arxiv.org/pdf/2303.12419

代码/Code: https://github.com/xu5zhao/bicro

Balanced Spherical Grid for Egocentric View Synthesis

论文/Paper: http://arxiv.org/pdf/2303.12408

代码/Code: https://github.com/changwoonchoi/EgoNeRF

Rigidity-Aware Detection for 6D Object Pose Estimation

论文/Paper: http://arxiv.org/pdf/2303.12396

代码/Code: None

Weakly Supervised Video Representation Learning with Unaligned Text for Sequential Videos

论文/Paper: http://arxiv.org/pdf/2303.12370

代码/Code: https://github.com/svip-lab/weaksvr

Re-thinking Federated Active Learning based on Inter-class Diversity

论文/Paper: http://arxiv.org/pdf/2303.12317

代码/Code: https://github.com/raymin0223/logo

Curvature-Balanced Feature Manifold Learning for Long-Tailed Classification

论文/Paper: http://arxiv.org/pdf/2303.12307

代码/Code: None

Object Pose Estimation with Statistical Guarantees: Conformal Keypoint Detection and Geometric Uncertainty Propagation

论文/Paper: http://arxiv.org/pdf/2303.12246

代码/Code: None

MAGVLT: Masked Generative Vision-and-Language Transformer

论文/Paper: http://arxiv.org/pdf/2303.12208

代码/Code: None

Learning a Depth Covariance Function

论文/Paper: http://arxiv.org/pdf/2303.12157

代码/Code: None

Positive-Augmented Constrastive Learning for Image and Video Captioning Evaluation

论文/Paper: http://arxiv.org/pdf/2303.12112

代码/Code: https://github.com/aimagelab/pacscore

Music-Driven Group Choreography

论文/Paper: http://arxiv.org/pdf/2303.12337

代码/Code: None