3.2 注意力机制Attention

注意力函数可以描述为将查询和一组键值对映射到输出的过程,其中查询、键、值和输出都是向量。输出被计算为值的加权和,其中每个值的权重由查询与相应键的兼容性函数计算得出。

3.2.1 缩放点积注意力 Scaled Dot-Product Attention

**dot-product点积 通过矩阵乘法实现。

**softmax:在深度学习中,Softmax函数常用于神经网络的输出层,以将原始的输出值转化为概率分布,从而使得每个类别的概率值在0到1之间,并且所有类别的概率之和为1。这使得Softmax函数特别适用于多类分类问题,其中模型需要预测输入样本属于多个可能类别中的哪一个。

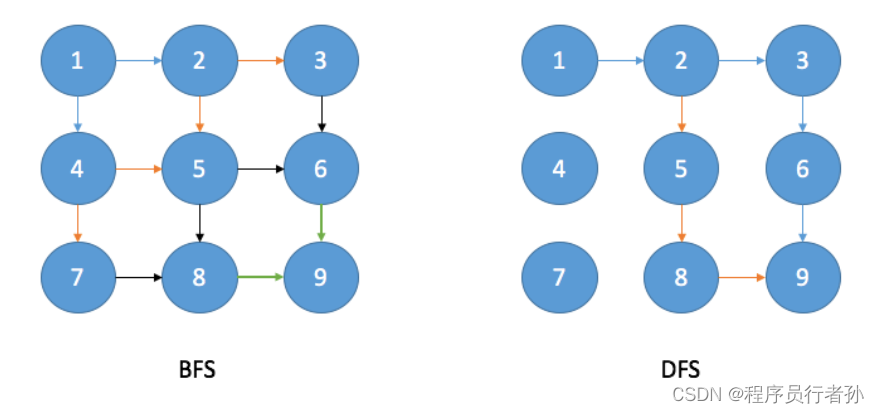

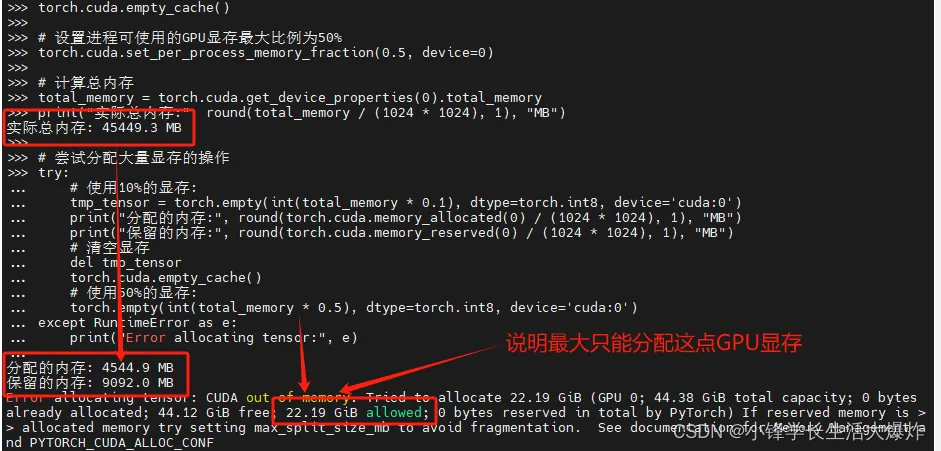

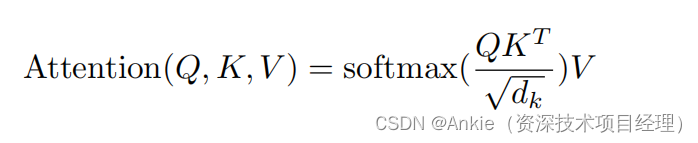

我们将我们特定的注意力机制称为“缩放点积注意力”(图2)。输入包括维度为dk的查询和键,以及维度为dv的值。我们计算查询与所有键的点积,每个都除以√dk,然后应用softmax函数来获得值上的权重。

在实践中,我们同时对一组查询计算注意力函数,并将它们打包成矩阵Q。键和值也打包成矩阵K和V。我们计算输出的矩阵为:

最常用的两种注意力函数是加性注意力[2]和点积(乘性)注意力。点积注意力与我们的算法相同,除了缩放因子1/√dk。加性注意力使用一个具有单个隐藏层的前馈网络来计算兼容性函数。虽然这两种注意力函数在理论复杂度上相似,但点积注意力在实践中更快且空间效率更高,因为它可以使用高度优化的矩阵乘法代码实现。

对于较小的dk值,这两种机制的表现相似,但对于较大的dk值,没有缩放的加性注意力表现优于点积注意力[3]。我们怀疑对于较大的dk值,点积的幅度会变得很大,将softmax函数推向梯度极小的区域4。为了抵消这种影响,我们将点积缩放了1/√dk。

3.2.2 多头注意力Multi-Head Attention

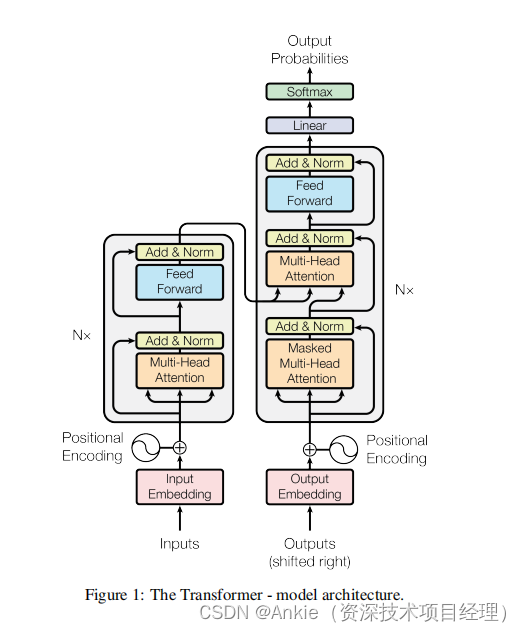

与其使用具有dmodel维度的键、值和查询来执行单一的注意力函数,我们发现将查询、键和值分别通过h次不同的学习线性投影,线性投影到dk、dk和dv维度上是有益的。然后,我们在这些投影后的查询、键和值的每个版本上并行执行注意力函数,得到dv维度的输出值。这些输出值被拼接起来,并再次进行投影,得到最终的值,如图2所示。

多头注意力允许模型在不同的位置同时关注来自不同表示子空间的信息。使用单个注意力头时,平均值会抑制这种效果。

其中,投影是参数矩阵Wi^Q ∈ R^(dmodel×dk)、Wi^K ∈ R^(dmodel×dk)、Wi^V ∈ R^(dmodel×dv) 和 WO ∈ R^(hdv×dmodel)。

在这项工作中,我们使用了h = 8个并行的注意力层,或称为“头”。对于每一个头,我们使用dk = dv = dmodel/h = 64。由于每个头的维度减少,总计算成本与具有完整维度的单头注意力相似。

权重矩阵 (W) 是通过模型训练学习得到的。

3.2.3 注意力机制在模型中的应用

Transformer以三种不同的方式使用多头注意力:

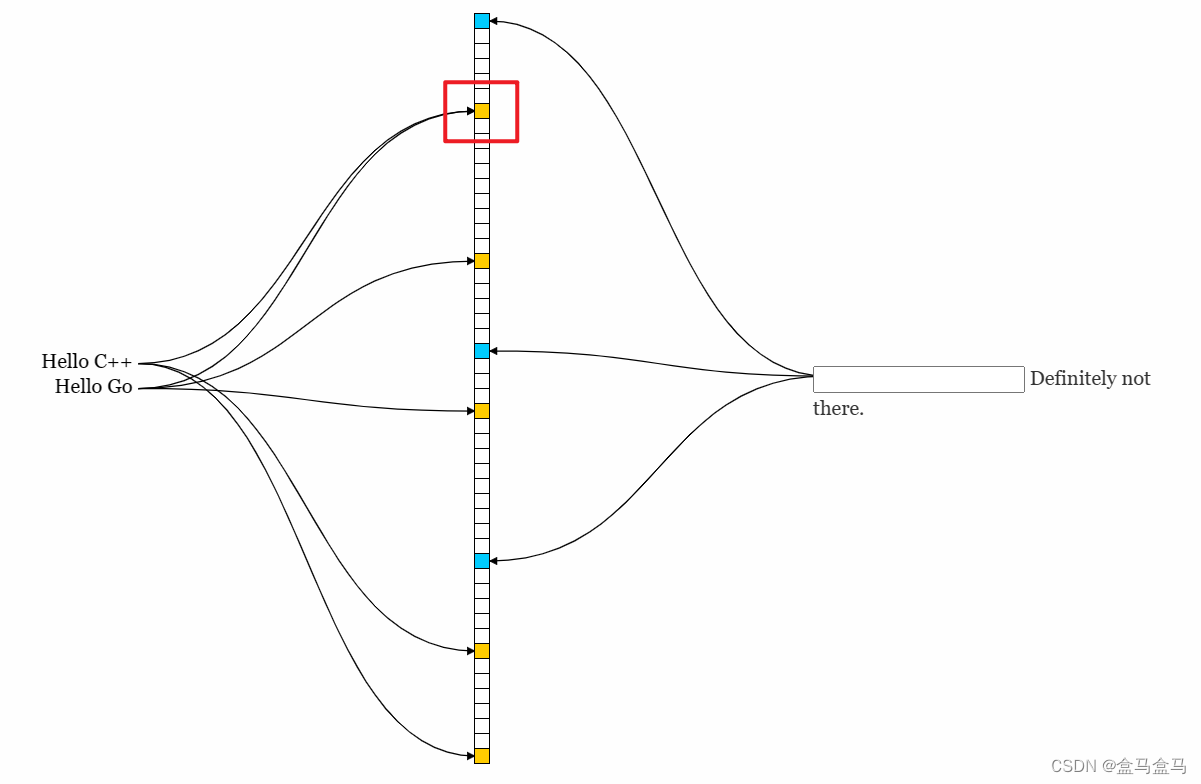

• 在“编码器-解码器注意力”层中,查询来自上一解码器层,而记忆键和值则来自编码器的输出。这使得解码器中的每个位置都可以关注输入序列中的所有位置。这模仿了序列到序列模型(如[31, 2, 8])中的典型编码器-解码器注意力机制。

• 编码器包含自注意力层。在自注意力层中,所有的键、值和查询都来自同一位置,在这种情况下,它们来自编码器中前一层的输出。编码器中的每个位置都可以关注编码器中前一层中的所有位置。

• 类似地,解码器中的自注意力层允许解码器中的每个位置关注解码器中直到并包括该位置的所有位置。我们需要防止解码器中的信息向左流动,以保持自回归属性。我们在缩放点积注意力内部通过屏蔽(设置为−∞)softmax输入中对应于非法连接的所有值来实现这一点。请参阅图2。

3.3 位置前馈网络Position-wise Feed-Forward Networks

在深度学习的领域里,Feed-Forward(前馈)是一个神经网络模块,由全连接层(FC)与激活函数(如ReLu)组成,通常用于处理序列数据或在深度学习模型的前馈过程中。在Transformer这类模型中,前馈全连接层是一个具有两层线性层的全连接网络,其作用是通过增加两层网络来增强模型的能力,以考虑注意力机制可能对复杂过程的拟合程度不够的问题。

除了注意力子层外,编码器和解码器中的每一层都包含一个全连接的前馈网络,该网络分别且相同地应用于每个位置。这包括两个线性变换,中间有一个ReLU激活函数。

尽管线性变换在不同位置上是相同的,但它们从一层到另一层使用不同的参数。另一种描述方式是将其视为两个核大小为1的卷积。输入和输出的维度是dmodel = 512,而中间层的维度是dff = 2048。

3.4 嵌入和Softmax Embeddings and Softmax

与其他序列转换模型类似,我们使用学习的嵌入来将输入标记和输出标记转换为dmodel维度的向量。我们还使用通常的线性变换和softmax函数来将解码器输出转换为预测的下一个标记概率。在我们的模型中,我们在两个嵌入层和pre-softmax线性变换之间共享相同的权重矩阵。在嵌入层中,我们将这些权重乘以√dmodel。

3.5 位置编码Positional Encoding

由于我们的模型不包含循环和卷积,为了让模型能够利用序列的顺序,我们必须注入一些关于序列中标记的相对或绝对位置的信息。为此,我们在编码器和解码器堆栈的底部向输入嵌入添加“位置编码”。位置编码与嵌入具有相同的维度dmodel,因此可以将两者相加。位置编码有很多选择,可以是学习的也可以是固定的[8]。

在这项工作中,我们使用不同频率的正弦和余弦函数作为位置编码:

其中,pos表示位置,i表示维度。也就是说,位置编码的每个维度都对应一个正弦波。这些正弦波的波长从2π到10000 · 2π形成几何级数。

我们选择这个函数是因为我们假设它能使模型更容易地学会根据相对位置进行关注,因为对于任何固定的偏移量k,P Epos+k都可以表示为P Epos的线性函数。

我们还尝试使用学习的位置嵌入[8]进行实验,发现这两种版本产生了几乎相同的结果(参见表3第(E)行)。我们选择正弦波版本是因为它可能允许模型外推到比训练过程中遇到的序列更长的长度。

4 为什么是自注意力Why Self-Attention

在本节中,我们将从多个方面比较自注意力层与常用于将一个可变长度的符号表示序列(x1, ..., xn)映射到另一个等长序列(z1, ..., zn)的循环和卷积层,其中xi, zi ∈ Rd,如典型序列转换编码器或解码器中的隐藏层。为了说明我们使用自注意力的原因,我们考虑了三个要求。

一个是每层的总计算复杂度。

另一个是可以并行化的计算量,这通过所需的最少顺序操作数来衡量。

第三个是网络中长期依赖关系的路径长度。学习长期依赖关系在许多序列转换任务中是一个关键挑战。影响学习这种依赖关系能力的一个关键因素是前向和后向信号在网络中必须遍历的路径长度。输入和输出序列中任意位置组合之间的这些路径越短,学习长期依赖关系就越容易。因此,我们还将比较由不同类型层组成的网络中任意两个输入和输出位置之间的最大路径长度。

如表1所示,自注意力层通过固定数量的顺序执行操作连接所有位置,而循环层则需要O(n)个顺序操作。在计算复杂度方面,当序列长度n小于表示维度d时,自注意力层比循环层更快。这在机器翻译中最先进的模型所使用的句子表示中通常是这种情况,例如单词片段和字节对表示。为了提高涉及非常长序列的任务的计算性能,自注意力可以限制为仅考虑以相应输出位置为中心的输入序列大小为r的邻域。这将使最大路径长度增加到O(n/r)。我们计划在未来的工作中进一步研究这种方法。

具有核宽度k < n的单个卷积层不会连接所有输入和输出位置对。在连续核的情况下,要这样做需要堆叠O(n/k)个卷积层,或在扩张卷积[15]的情况下需要O(logk(n))个,这会增加网络中任意两个位置之间的最长路径长度。卷积层通常比循环层贵k倍。然而,可分离卷积[6]大大降低了复杂性,变为O(k · n · d + n · d^2)。即使k = n,可分离卷积的复杂性也等于我们模型中采用的自注意力层和逐点前馈层的组合。

作为附带的好处,自注意力可能会产生更具可解释性的模型。我们检查模型中的注意力分布,并在附录中呈现和讨论示例。不仅单个注意力头显然学会了执行不同的任务,而且许多注意力头似乎表现出与句子的句法和语义结构相关的行为。

Ankie的评论:

相比较之前RNN等方案,attention机制非常善于处理token之间的关系。而且运算量比RNN小很多。最终实验结果证明 transformer明显提高了机器翻译的准确率。