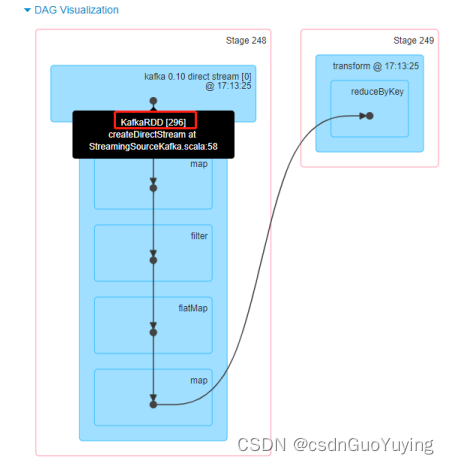

4.4 获取偏移量

当SparkStreaming集成Kafka时,无论是Old Consumer API中Direct方式还是New Consumer API方式获取的数据,每批次的数据封装在KafkaRDD中,其中包含每条数据的元数据信息。

文档:http://spark.apache.org/docs/2.4.5/streaming-kafka-0-10-integration.html#obtaining-offsets

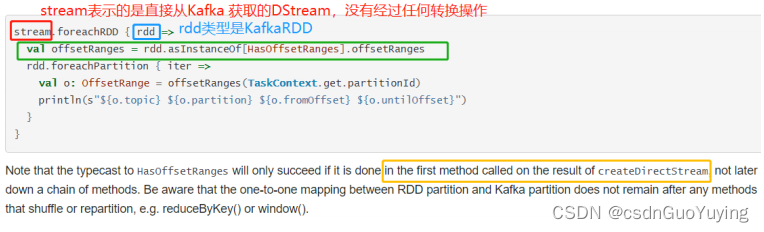

具体说明如下:

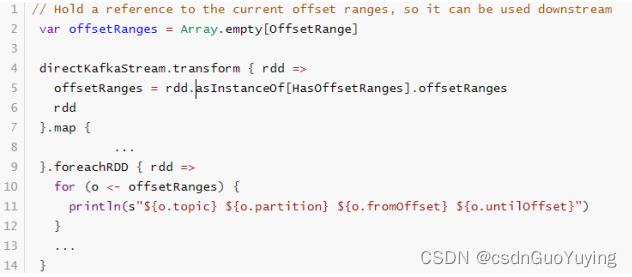

获取偏移量信息代码如下:

代码演示获取每批次RDD中对应Kafka分区中数据偏移量信息:

具体演示代码如下:

import java.util.Date

import org.apache.commons.lang3.time.FastDateFormat

import org.apache.kafka.clients.consumer.ConsumerRecord

import org.apache.kafka.common.serialization.StringDeserializer

import org.apache.spark.SparkConf

import org.apache.spark.rdd.RDD

import org.apache.spark.streaming.{Seconds, StreamingContext}

import org.apache.spark.streaming.dstream.DStream

import org.apache.spark.streaming.kafka010._

/**

* 集成Kafka,实时消费Topic中数据,获取每批次数据对应Topic各个分区数据偏移量

*/

object StreamingKafkaOffset {

def main(args: Array[String]): Unit = {

// TODO: 1. 构建StreamingContext流式上下文实例对象

val ssc: StreamingContext = {

// a. 创建SparkConf对象,设置应用配置信息

val sparkConf = new SparkConf()

.setAppName(this.getClass.getSimpleName.stripSuffix("$"))

.setMaster("local[3]")

// b.创建流式上下文对象, 传递SparkConf对象,TODO: 时间间隔 -> 用于划分流式数据为很多批次Batch

val context = new StreamingContext(sparkConf, Seconds(5))

// c. 返回

context

}

// 2. 读取Kafka Topic中数据

/*

def createDirectStream[K, V](

ssc: StreamingContext,

locationStrategy: LocationStrategy,

consumerStrategy: ConsumerStrategy[K, V]

): InputDStream[ConsumerRecord[K, V]]

*/

// i.位置策略

val locationStrategy: LocationStrategy = LocationStrategies.PreferConsistent

/*

def Subscribe[K, V](

topics: ju.Collection[jl.String],

kafkaParams: ju.Map[String, Object]

): ConsumerStrategy[K, V]

*/

// ii.读取哪些Topic数据

val topics = Array("wc-topic")

// iii.消费Kafka 数据配置参数

val kafkaParams = Map[String, Object](

"bootstrap.servers" -> "node1.itcast.cn:9092",

"key.deserializer" -> classOf[StringDeserializer],

"value.deserializer" -> classOf[StringDeserializer],

"group.id" -> "group_id_streaming_0001",

"auto.offset.reset" -> "latest",

"enable.auto.commit" -> (false: java.lang.Boolean)

)

// iv.消费数据策略

val consumerStrategy: ConsumerStrategy[String, String] = ConsumerStrategies.Subscribe(

topics, kafkaParams

)

// v.采用新消费者API获取数据,类似于Direct方式

val kafkaDStream: DStream[ConsumerRecord[String, String]] = KafkaUtils.createDirectStream(

ssc, locationStrategy, consumerStrategy

)

// TODO:其一、定义数组存储每批次数据对应RDD中各个分区的Topic Partition中偏移量信息

var offsetRanges: Array[OffsetRange] = Array.empty

// 3. 对每批次的数据进行词频统计

val resultDStream: DStream[(String, Int)] = kafkaDStream.transform(kafkaRDD => {

// TODO:其二、直接从Kafka获取的每批次KafkaRDD中获取偏移量信息

offsetRanges = kafkaRDD.asInstanceOf[HasOffsetRanges].offsetRanges

val resultRDD: RDD[(String, Int)] = kafkaRDD

.map(record => record.value()) // 获取Message数据

// 过滤不合格的数据

.filter(line => null != line && line.trim.length > 0)

// 按照分隔符划分单词

.flatMap(line => line.trim.split("\\s+"))

// 转换数据为二元组,表示每个单词出现一次

.map(word => (word, 1))

// 按照单词分组,聚合统计

.reduceByKey((tmp, item) => tmp + item)

resultRDD

})

// 4. 将结果数据输出 -> 将每批次的数据处理以后输出

resultDStream.foreachRDD{ (rdd, time) =>

val batchTime: String = FastDateFormat.getInstance("yyyy/MM/dd HH:mm:ss")

.format(new Date(time.milliseconds))

println("-------------------------------------------")

println(s"Time: $batchTime")

println("-------------------------------------------")

// 先判断RDD是否有数据,有数据在输出

if(!rdd.isEmpty()){

rdd

// 对于结果RDD输出,需要考虑降低分区数目

.coalesce(1)

// 对分区数据操作

.foreachPartition{iter =>iter.foreach(item => println(item))}

}

// TODO: 其三、当DStream进行Output操作完成以后,更新偏移量至外部存储系统(如Zookeeper、Redis等)

for (offsetRange <- offsetRanges) {

println(s"topic: ${offsetRange.topic} partition: ${offsetRange.partition} offsets:${o

ffsetRange.fromOffset} to ${offsetRange.untilOffset}")

}

}

// 5. 对于流式应用来说,需要启动应用

ssc.start()

// 流式应用启动以后,正常情况一直运行(接收数据、处理数据和输出数据),除非人为终止程序或者程序异常停止

ssc.awaitTermination()

// 关闭流式应用(参数一:是否关闭SparkContext,参数二:是否优雅的关闭)

ssc.stop(stopSparkContext = true, stopGracefully = true)

}

}

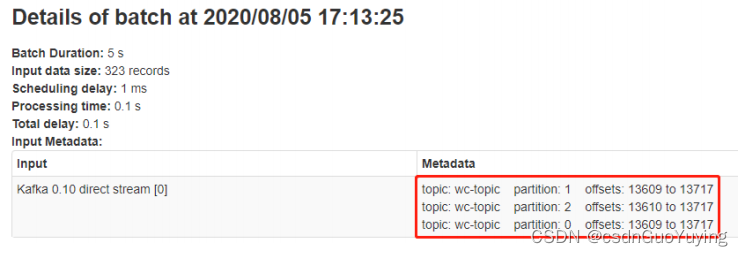

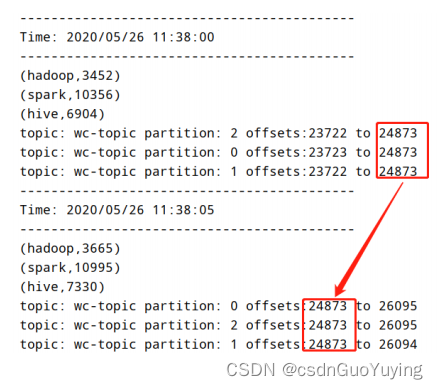

运行Streaming应用程序,控制台输出结果如下:

5. 应用案例:百度搜索风云榜

百度搜索风云榜(http://top.baidu.com/)以数亿网民的单日搜索行为作为数据基础,以搜索关键词为统计对象建立权威全面的各类关键词排行榜,以榜单形式向用户呈现基于百度海量搜索数据的排行信息,线上覆盖十余个行业类别,一百多个榜单。

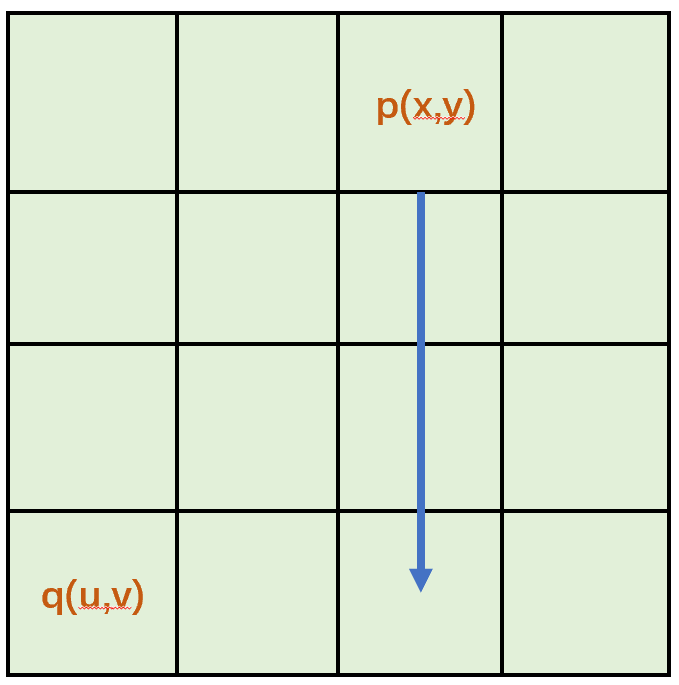

在【热点榜单】中,可以看到依据搜索关键词实时统计各种维度热点,下图展示【实时热点】。

5.1 业务场景

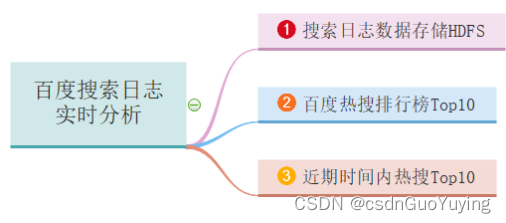

仿【百度搜索风云榜】对用户使用百度搜索时日志进行分析:【百度搜索日志实时分析】,主要业务需求如下三个方面:

- 业务一:搜索日志数据存储HDFS,实时对日志数据进行ETL提取转换,存储HDFS文件系统;

- 业务二:百度热搜排行榜Top10,累加统计所有用户搜索词次数,获取Top10搜索词及次数;

- 业务三:近期时间内热搜Top10,统计最近一段时间范围(比如,最近半个小时或最近2个小时)内用户搜索词次数,获取Top10搜索词及次数;

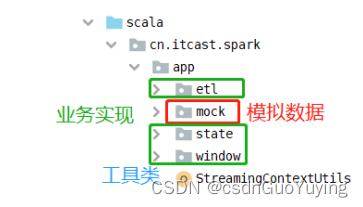

开发Maven Project中目录结构如下所示:

5.2 初始化环境

编程实现业务之前,首先编写程序模拟产生用户使用百度搜索产生日志数据和创建工具类StreamingContextUtils提供StreamingContext对象与从Kafka接收数据方法。

创建 Topic

启动Kafka Broker服务,创建Topic【search-log-topic】,命令如下所示:

# 1. 启动Zookeeper 服务

zookeeper-daemon.sh start

# 2. 启动Kafka 服务

kafka-daemon.sh start

# 3. Create Topic

kafka-topics.sh --create --topic search-log-topic \

--partitions 3 --replication-factor 1 --zookeeper node1.itcast.cn:2181/kafka200

# List Topics

kafka-topics.sh --list --zookeeper node1.itcast.cn:2181/kafka200

# Producer

kafka-console-producer.sh --topic search-log-topic --broker-list node1.itcast.cn:9092

# Consumer

kafka-console-consumer.sh --topic search-log-topic \

--bootstrap-server node1.itcast.cn:9092 --from-beginning

模拟日志数据

模拟用户搜索日志数据,字段信息封装到CaseClass样例类【SearchLog】类,代码如下:

package cn.itcast.spark.app.mock

/**

* 用户百度搜索时日志数据封装样例类CaseClass

* <p>

* @param sessionId 会话ID

* @param ip IP地址

* @param datetime 搜索日期时间

* @param keyword 搜索关键词

*/

case class SearchLog(

sessionId: String, //

ip: String, //

datetime: String, //

keyword: String //

) {

override def toString: String = s"$sessionId,$ip,$datetime,$keyword"

}

模拟产生搜索日志数据类【MockSearchLogs】具体代码如下:

package cn.itcast.spark.app.mock

import java.util.{Properties, UUID}

import org.apache.commons.lang3.time.FastDateFormat

import org.apache.kafka.clients.producer.{KafkaProducer, ProducerRecord}

import org.apache.kafka.common.serialization.StringSerializer

import scala.util.Random

/**

* 模拟产生用户使用百度搜索引擎时,搜索查询日志数据,包含字段为:

* uid, ip, search_datetime, search_keyword

*/

object MockSearchLogs {

def main(args: Array[String]): Unit = {

// 搜索关键词,直接到百度热搜榜获取即可

val keywords: Array[String] = Array("罗志祥", "谭卓疑", "当当网", "裸海蝶", "张建国")

// 发送Kafka Topic

val props = new Properties()

props.put("bootstrap.servers", "node1.itcast.cn:9092")

props.put("acks", "1")

props.put("retries", "3")

props.put("key.serializer", classOf[StringSerializer].getName)

props.put("value.serializer", classOf[StringSerializer].getName)

val producer = new KafkaProducer[String, String](props)

val random: Random = new Random()

while (true){

// 随机产生一条搜索查询日志

val searchLog: SearchLog = SearchLog(

getUserId(), //

getRandomIp(), //

getCurrentDateTime(), //

keywords(random.nextInt(keywords.length)) //

)

println(searchLog.toString)

Thread.sleep(10 + random.nextInt(100))

val record = new ProducerRecord[String, String]("search-log-topic", searchLog.toString)

producer.send(record)

}

// 关闭连接

producer.close()

}

/**

* 随机生成用户SessionId

*/

def getUserId(): String = {

val uuid: String = UUID.randomUUID().toString

uuid.replaceAll("-", "").substring(16)

}

/**

* 获取当前日期时间,格式为yyyyMMddHHmmssSSS

*/

def getCurrentDateTime(): String = {

val format = FastDateFormat.getInstance("yyyyMMddHHmmssSSS")

val nowDateTime: Long = System.currentTimeMillis()

format.format(nowDateTime)

}

/**

* 获取随机IP地址

*/

def getRandomIp(): String = {

// ip范围

val range: Array[(Int, Int)] = Array(

(607649792,608174079), //36.56.0.0-36.63.255.255

(1038614528,1039007743), //61.232.0.0-61.237.255.255

(1783627776,1784676351), //106.80.0.0-106.95.255.255

(2035023872,2035154943), //121.76.0.0-121.77.255.255

(2078801920,2079064063), //123.232.0.0-123.235.255.255

(-1950089216,-1948778497),//139.196.0.0-139.215.255.255

(-1425539072,-1425014785),//171.8.0.0-171.15.255.255

(-1236271104,-1235419137),//182.80.0.0-182.92.255.255

(-770113536,-768606209),//210.25.0.0-210.47.255.255

(-569376768,-564133889) //222.16.0.0-222.95.255.255

)

// 随机数:IP地址范围下标

val random = new Random()

val index = random.nextInt(10)

val ipNumber: Int = range(index)._1 + random.nextInt(range(index)._2 - range(index)._1)

//println(s"ipNumber = ${ipNumber}")

// 转换Int类型IP地址为IPv4格式

number2IpString(ipNumber)

}

/**

* 将Int类型IPv4地址转换为字符串类型

*/

def number2IpString(ip: Int): String = {

val buffer: Array[Int] = new Array[Int](4)

buffer(0) = (ip >> 24) & 0xff

buffer(1) = (ip >> 16) & 0xff

buffer(2) = (ip >> 8) & 0xff

buffer(3) = ip & 0xff

// 返回IPv4地址

buffer.mkString(".")

}

}

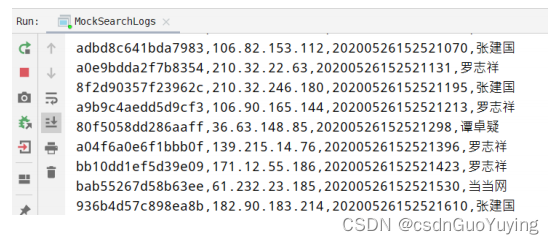

运行应用程序,源源不断产生日志数据,发送至Kafka(同时在控制台打印),截图如下:

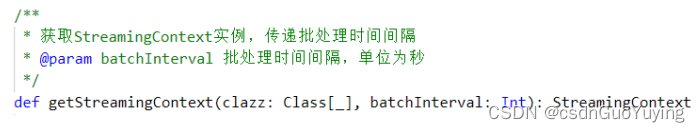

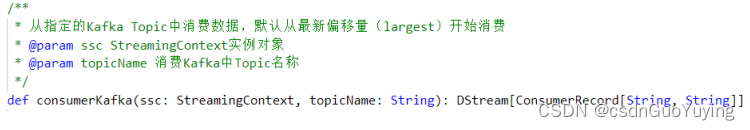

StreamingContextUtils 工具类

所有SparkStreaming应用都需要构建StreamingContext实例对象,并且从采用New Kafka Consumer API消费Kafka数据,编写工具类【StreamingContextUtils】,提供两个方法:

方法一:getStreamingContext,获取StreamingContext实例对象

方法二:consumerKafka,消费Kafka Topic中数据

具体代码如下:

package cn.itcast.spark.app

import org.apache.kafka.clients.consumer.ConsumerRecord

import org.apache.kafka.common.serialization.StringDeserializer

import org.apache.spark.SparkConf

import org.apache.spark.streaming.dstream.DStream

import org.apache.spark.streaming.kafka010._

import org.apache.spark.streaming.{Seconds, StreamingContext}

/**

* 工具类提供:构建流式应用上下文StreamingContext实例对象和从Kafka Topic消费数据

*/

object StreamingContextUtils {

/**

* 获取StreamingContext实例,传递批处理时间间隔

* @param batchInterval 批处理时间间隔,单位为秒

*/

def getStreamingContext(clazz: Class[_], batchInterval: Int): StreamingContext = {

// i. 创建SparkConf对象,设置应用配置信息

val sparkConf = new SparkConf()

.setAppName(clazz.getSimpleName.stripSuffix("$"))

.setMaster("local[3]")

// 设置Kryo序列化

.set("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.registerKryoClasses(Array(classOf[ConsumerRecord[String, String]]))

// ii.创建流式上下文对象, 传递SparkConf对象和时间间隔

val context = new StreamingContext(sparkConf, Seconds(batchInterval))

// iii. 返回

context

}

/**

* 从指定的Kafka Topic中消费数据,默认从最新偏移量(largest)开始消费

* @param ssc StreamingContext实例对象

* @param topicName 消费Kafka中Topic名称

*/

def consumerKafka(ssc: StreamingContext, topicName: String): DStream[ConsumerRecord[String, String]] = {

// i.位置策略

val locationStrategy: LocationStrategy = LocationStrategies.PreferConsistent

// ii.读取哪些Topic数据

val topics = Array(topicName)

// iii.消费Kafka 数据配置参数

val kafkaParams = Map[String, Object](

"bootstrap.servers" -> "node1.itcast.cn:9092",

"key.deserializer" -> classOf[StringDeserializer],

"value.deserializer" -> classOf[StringDeserializer],

"group.id" -> "group_id_streaming_0001",

"auto.offset.reset" -> "latest",

"enable.auto.commit" -> (false: java.lang.Boolean)

)

// iv.消费数据策略

val consumerStrategy: ConsumerStrategy[String, String] = ConsumerStrategies.Subscribe(

topics, kafkaParams

)

// v.采用新消费者API获取数据,类似于Direct方式

val kafkaDStream: DStream[ConsumerRecord[String, String]] = KafkaUtils.createDirectStream(

ssc, locationStrategy, consumerStrategy

)

// vi.返回DStream

kafkaDStream

}

}

![“速通“ 老生常谈的HashMap [实现原理源码解读]](https://img-blog.csdnimg.cn/198fd6850c4f490b8ecd0ee15cf11c24.gif)