一、Deep Learning相关

来源于 深度学习-百度百科

1.1 深度学习

深度学习(DL,Deep Learning)是机器学习(ML,Machine

Learning)领域中一个新的研究方向,它被引入机器学习使其更接近于最初的目标——人工智能(AI,Artificial

Intelligence)。

深度学习是学习样本数据的内在规律和表示层次,这些学习过程中获得的信息对诸如文字、图像和声音等数据的解释有很大的帮助。它的最终目标是让机器能够像人一样具有分析学习能力,能够识别文字、图像和声音等数据。

深度学习是一个复杂的机器学习算法,在语音和图像识别方面取得的效果,远远超过先前相关技术。深度学习在搜索技术、数据挖掘、机器学习、机器翻译、自然语言处理、多媒体学习、语音、推荐和个性化技术,以及其他相关领域都取得了很多成果。深度学习使机器模仿视听和思考等人类的活动,解决了很多复杂的模式识别难题,使得人工智能相关技术取得了很大进步。

简介:

深度学习是一类模式分析方法的统称,就具体研究内容而言,主要涉及三类方法:

(1)基于卷积运算的神经网络系统,即卷积神经网络(CNN)。

(2)基于多层神经元的自编码神经网络,包括自编码(Auto encoder)以及近年来受到广泛关注的稀疏编码两类(Sparse Coding)。

(3)以多层自编码神经网络的方式进行预训练,进而结合鉴别信息进一步优化神经网络权值的深度置信网络(DBN)。

通过多层处理,逐渐将初始的“低层”特征表示转化为“高层”特征表示后,用“简单模型”即可完成复杂的分类等学习任务。由此可将深度学习理解为进行“特征学习”(feature learning)或“表示学习”(representation learning)。

以往在机器学习用于现实任务时,描述样本的特征通常需由人类专家来设计,这成为“特征工程”(feature engineering)。众所周知,特征的好坏对泛化性能有至关重要的影响,人类专家设计出好特征也并非易事;特征学习(表征学习)则通过机器学习技术自身来产生好特征,这使机器学习向“全自动数据分析”又前进了一步。

近年来,研究人员也逐渐将这几类方法结合起来,如对原本是以有监督学习为基础的卷积神经网络结合自编码神经网络进行无监督的预训练,进而利用鉴别信息微调网络参数形成的卷积深度置信网络。与传统的学习方法相比,深度学习方法预设了更多的模型参数,因此模型训练难度更大,根据统计学习的一般规律知道,模型参数越多,需要参与训练的数据量也越大。

20世纪八九十年代由于计算机计算能力有限和相关技术的限制,可用于分析的数据量太小,深度学习在模式分析中并没有表现出优异的识别性能。自从2006年,Hinton等提出快速计算受限玻耳兹曼机(RBM)网络权值及偏差的CD-K算法以后,RBM就成了增加神经网络深度的有力工具,导致后面使用广泛的DBN(由Hinton等开发并已被微软等公司用于语音识别中)等深度网络的出现。与此同时,稀疏编码等由于能自动从数据中提取特征也被应用于深度学习中。基于局部数据区域的卷积神经网络方法近年来也被大量研究。

释义

深度学习是机器学习的一种,而机器学习是实现人工智能的必经路径。深度学习的概念源于人工神经网络的研究,含多个隐藏层的多层感知器就是一种深度学习结构。深度学习通过组合低层特征形成更加抽象的高层表示属性类别或特征,以发现数据的分布式特征表示。研究深度学习的动机在于建立模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本等。

从一个输入中产生一个输出所涉及的计算可以通过一个流向图(flow

graph)来表示:流向图是一种能够表示计算的图,在这种图中每一个节点表示一个基本的计算以及一个计算的值,计算的结果被应用到这个节点的子节点的值。考虑这样一个计算集合,它可以被允许在每一个节点和可能的图结构中,并定义了一个函数族。输入节点没有父节点,输出节点没有子节点。这种流向图的一个特别属性是深度(depth):从一个输入到一个输出的最长路径的长度。

传统的前馈神经网络能够被看作拥有等于层数的深度(比如对于输出层为隐层数加1)。SVMs有深度2(一个对应于核输出或者特征空间,另一个对应于所产生输出的线性混合)。人工智能研究的方向之一,是以所谓 “专家系统” 为代表的,用大量 “如果-就”(If -Then)规则定义的,自上而下的思路。人工神经网络(Artificial Neural

Network),标志着另外一种自下而上的思路。神经网络没有一个严格的正式定义。它的基本特点,是试图模仿大脑的神经元之间传递,处理信息的模式。

1.2 特点

区别于传统的浅层学习,深度学习的不同在于:

(1)强调了模型结构的深度,通常有5层、6层,甚至10多层的隐层节点;

(2)明确了特征学习的重要性。也就是说,通过逐层特征变换,将样本在原空间的特征表示变换到一个新特征空间,从而使分类或预测更容易。与人工规则构造特征的方法相比,利用大数据来学习特征,更能够刻画数据丰富的内在信息。

通过设计建立适量的神经元计算节点和多层运算层次结构,选择合适的输入层和输出层,通过网络的学习和调优,建立起从输入到输出的函数关系,虽然不能100%找到输入与输出的函数关系,但是可以尽可能的逼近现实的关联关系。使用训练成功的网络模型,就可以实现我们对复杂事务处理的自动化要求。

1.3 深度学习典型模型

典型的深度学习模型有卷积神经网络(convolutional neural network)、DBN和堆栈自编码网络(stacked

auto-encoder network)模型等,下面对这些模型进行描述。卷积神经网络模型

在无监督预训练出现之前,训练深度神经网络通常非常困难,而其中一个特例是卷积神经网络。卷积神经网络受视觉系统的结构启发而产生。第一个卷积神经网络计算模型是在Fukushima的神经认知机中提出的,基于神经元之间的局部连接和分层组织图像转换,将有相同参数的神经元应用于前一层神经网络的不同位置,得到一种平移不变神经网络结构形式。后来,Le Cun等人在该思想的基础上,用误差梯度设计并训练卷积神经网络,在一些模式识别任务上得到优越的性能。至今,基于卷积神经网络的模式识别系统是最好的实现系统之一,尤其在手写体字符识别任务上表现出非凡的性能。

深度信任网络模型

DBN可以解释为贝叶斯概率生成模型,由多层随机隐变量组成,上面的两层具有无向对称连接,下面的层得到来自上一层的自顶向下的有向连接,最底层单元的状态为可见输入数据向量。DBN由若2F结构单元堆栈组成,结构单元通常为RBM(Restricted Boltzmann Machine,受限玻尔兹曼机) 。堆栈中每个RBM单元的可视层神经元数量等于前一RBM单元的隐层神经元数量。根据深度学习机制,采用输入样例训练第一层RBM单元,并利用其输出训练第二层RBM模型,将RBM模型进行堆栈通过增加层来改善模型性能。在无监督预训练过程中,DBN编码输入到顶层RBM后,解码顶层的状态到最底层的单元,实现输入的重构。RBM作为DBN的结构单元,与每一层DBN共享参数。

堆栈自编码网络模型

堆栈自编码网络的结构与DBN类似,由若干结构单元堆栈组成,不同之处在于其结构单元为自编码模型(auto-en-coder)而不是RBM。自编码模型是一个两层的神经网络,第一层称为编码层,第二层称为解码层。

1.4 深度学习训练过程

2006年,Hinton提出了在非监督数据上建立多层神经网络的一个有效方法,具体分为两步:首先逐层构建单层神经元,这样每次都是训练一个单层网络;当所有层训练完后,使用wake-sleep算法进行调优。

将除最顶层的其他层间的权重变为双向的,这样最顶层仍然是一个单层神经网络,而其他层则变为了图模型。向上的权重用于“认知”,向下的权重用于“生成”。然后使用wake-sleep算法调整所有的权重。让认知和生成达成一致,也就是保证生成的最顶层表示能够尽可能正确的复原底层的节点。比如顶层的一个节点表示人脸,那么所有人脸的图像应该激活这个节点,并且这个结果向下生成的图像应该能够表现为一个大概的人脸图像。

wake-sleep算法分为**醒(wake)和睡(sleep)**两个部分。

wake阶段:认知过程,通过外界的特征和向上的权重产生每一层的抽象表示,并且使用梯度下降修改层间的下行权重。

sleep阶段:生成过程,通过顶层表示和向下权重,生成底层的状态,同时修改层间向上的权重。

自下上升的非监督学习

就是从底层开始,一层一层地往顶层训练。采用无标定数据(有标定数据也可)分层训练各层参数,这一步可以看作是一个无监督训练过程,这也是和传统神经网络区别最大的部分,可以看作是特征学习过程。具体的,先用无标定数据训练第一层,训练时先学习第一层的参数,这层可以看作是得到一个使得输出和输入差别最小的三层神经网络的隐层,由于模型容量的限制以及稀疏性约束,使得得到的模型能够学习到数据本身的结构,从而得到比输入更具有表示能力的特征;在学习得到n-l层后,将n-l层的输出作为第n层的输入,训练第n层,由此分别得到各层的参数。 [6]

自顶向下的监督学习

就是通过带标签的数据去训练,误差自顶向下传输,对网络进行微调。基于第一步得到的各层参数进一步优调整个多层模型的参数,这一步是一个有监督训练过程。第一步类似神经网络的随机初始化初值过程,由于第一步不是随机初始化,而是通过学习输入数据的结构得到的,因而这个初值更接近全局最优,从而能够取得更好的效果。所以深度学习的良好效果在很大程度上归功于第一步的特征学习的过程。

1.5 深度学习应用

计算机视觉

香港中文大学的多媒体实验室是最早应用深度学习进行计算机视觉研究的华人团队。在世界级人工智能竞赛LFW(大规模人脸识别竞赛)上,该实验室曾力压FaceBook夺得冠军,使得人工智能在该领域的识别能力首次超越真人。 [

语音识别

微软研究人员通过与hinton合作,首先将RBM和DBN引入到语音识别声学模型训练中,并且在大词汇量语音识别系统中获得巨大成功,使得语音识别的错误率相对减低30%。但是,DNN还没有有效的并行快速算法,很多研究机构都是在利用大规模数据语料通过GPU平台提高DNN声学模型的训练效率。

在国际上,IBM、google等公司都快速进行了DNN语音识别的研究,并且速度飞快。

国内方面,阿里巴巴、科大讯飞、百度、中科院自动化所等公司或研究单位,也在进行深度学习在语音识别上的研究。

自然语言处理等其他领域

很多机构在开展研究,2013年,Tomas Mikolov、Kai Chen、Greg Corrado、Jeffrey Dean发表论文Efficient Estimation of Word Representations in Vector Space建立word2vector模型,与传统的词袋模型(bag of words)相比,word2vector能够更好地表达语法信息。深度学习在自然语言处理等领域主要应用于机器翻译以及语义挖掘等方面。

2020年,深度学习可以加速半导体封测创新。在降低重复性人工、提高良率、管控精度和效率、降低检测成本方面,AI深度学习驱动的AOI具有广阔的市场前景,但驾驭起来并不简单。

2020年4月13日,英国《自然·机器智能》杂志发表的一项医学与人工智能(AI)研究中,瑞士科学家介绍了一种人工智能系统可以几秒之内扫描心血管血流。这个深度学习模型有望让临床医师在患者接受核磁共振扫描的同时,实时观察血流变化,从而优化诊断工作流。

二、下载

1-下载Anoconda-https://www.anaconda.com/download/

2-下载Pycharm-https://www.jetbrains.com/pycharm/

3-下载-Cuda-https://developer.nvidia.com/cuda-toolkit-archive

4-下载-cudnn-注意访问较慢,下载前需要注册账号

CUDA Toolkit Documentation v12.0

CUDA Toolkit Documentation 12.1 Update 1

https://docs.nvidia.com/deeplearning/cudnn/developer-guide/index.html

NVIDIA Developer Program Supporting the Community That’s Changing the World

https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html

三、工具软件包介绍

3.1 Anaconda

Anaconda,中文大蟒蛇,是一个开源的Python发行版本,其包含了conda、Python等180多个科学包及其依赖项。

Anaconda包括Conda、Python以及一大堆安装好的工具包,比如:numpy、pandas等。

Miniconda包括Conda、Python

conda是一个开源的包、环境管理器,可以用于在同一个机器上安装不同版本的软件包及其依赖,并能够在不同的环境之间切换。

#基本用法:

conda clean

conda config

conda create

conda help

conda info

conda installconda list #罗列出所有已安装的科学包及其依赖项conda package

conda remove

conda search

conda uninstall

conda update

conda upgrade

3.2 CUDA

CUDA ,Compute Unified Device Architecture是NVIDIA,即英伟达推出的用于自家GPU的并行计算框架,CUDA只能在NVIDIA的GPU上运行,当要解决的计算问题是可以大量并行计算的时候才能发挥CUDA的作用。

CUDA是一个用于并行计算的平台以及API(Application Programming Interface),允许开发人员使用支持CUDA的GPU进行并行编程。GPU不能独立进行运算操作,需要通过PCI-Express总线(peripheral component interconnect express)连接CPU协同工作,所以使用GPU进行的并行计算可以被视为是CPU与GPU的异构计算架构,CPU负责处理逻辑复杂的串行部分,GPU负责处理数据密集的并行计算部分。

3.3 cuDNN

NVIDIA CUDA® 深度神经网络库 (cuDNN,CUDA Deep Neural Network library) 是一个 GPU 加速的 深度神经网络基元库,能够以高度优化的方式实现标准例程(如前向和反向卷积、池化层、归一化和激活层)。

NVIDIA推出的针对深度神经网络的加速库,是一个用于深层神经网络的GPU加速库。如果你要用GPU训练模型,cuDNN不是必须的,但是一般会采用这个加速库。

全球的深度学习研究人员和框架开发者都依赖 cuDNN 来实现高性能 GPU 加速。借助 cuDNN,研究人员和开发者可以专注于训练神经网络及开发软件应用,而不必花时间进行低层级的 GPU 性能调整。cuDNN 可加速广泛应用的深度学习框架,包括 Caffe2、Chainer、Keras、MATLAB、MxNet、PaddlePaddle、PyTorch 和 TensorFlow。如需获取经 NVIDIA 优化且已在框架中集成 cuDNN 的深度学习框架容器,请访问 NVIDIA GPU CLOUD 了解详情并开始使用。

3.4 CPU&GPU

中央处理器(Central Processing Unit,简称CPU)作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。CPU自产生以来,在逻辑结构、运行效率以及功能外延上取得了巨大发展。

CPU的主要功能有指令控制、操作控制、时间控制、数据加工、处理中断。

CPU由ALU(算术逻辑单元)、CU(控制器)、寄存器(PC-程序计数器、IR-指令寄存器、PSW、DR-数据寄存器、通用寄存器等)、中断系统组成。

图形处理器(英语:graphics processing unit,缩写:GPU),又称显示核心、视觉处理器、显示芯片,是一种专门在个人电脑、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上做图像和图形相关运算工作的微处理器。

GPU使显卡减少了对CPU的依赖,并进行部分原本CPU的工作,尤其是在3D图形处理时GPU所采用的核心技术有硬件T&L(几何转换和光照处理)、立方环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等,而硬件T&L技术可以说是GPU的标志。GPU的生产商主要有NVIDIA和ATI。

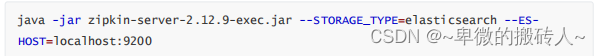

四、Welcome to the NVIDIA cuDNN developer community

Below are resources to get you started.

4.1 Installation

Support Matrix: Platform and software version compatibility

Installation Guide: Step-by-step instructions for installation and upgrade

4.2 Documentation

Developer Guide: Overview of programming model, features and formats supported

cuDNN API: Reference for cuDNN datatypes and APIs

4.3 Community

Developer Forum: Browse introductory “how-to” questions or discuss advanced tips-and-tricks for your application with the community

Bug Reporting: Help improve cuDNN by reporting bugs and filing enhancement requests for the cuDNN team

Have feedback? Send us an email developercontact@nvidia.com.